你的神经网络不起作用的37个理由

目录

1. 如何使用本指南?

2. 数据集问题

3. 数据规范化或增强的问题

4. 实现问题

5. 训练问题

1.如何使用本指南?

1. 从一个已知适用于这类数据的简单模型开始(例如,图像的VGG)。如果可能,使用标准损失。

2. 关闭所有的附加功能,例如正则化和数据增强。

3. 如果对一个模型进行微调,要仔细检查预处理,因为它应该与原始模型的训练相同。

4. 验证输入数据是否正确。

5. 从一个非常小的数据集(2-20个样本)开始。对它进行过度拟合,并逐渐添加更多的数据。

6. 开始逐步添加所有被省略的部分:增强/正则化、自定义损失函数、尝试更复杂的模型。

2.数据集问题

1.检查你的输入数据

2.尝试随机输入

3. 检查数据加载程序

4. 确保输入连接到输出

5. 输入和输出之间的关系是否过于随机?

6. 数据集中是否有太多噪音?

https://arxiv.org/pdf/1412.6596.pdf

7. 打乱数据集

8. 减少类别不平衡

https://machinelearningmastery.com/tactics-to-combat-imbalanced-classes-in-your-machine-learning-dataset/

9. 你有足够的训练样本吗?

https://stats.stackexchange.com/questions/226672/how-few-training-examples-is-too-few-when-training-a-neural-network/226693#226693

10. 确保你的批次中不只包含一个标签

11. 减少批量大小

https://arxiv.org/abs/1609.04836

3.数据则正则化或增强

12. 规范的功能

13. 你的数据增强太多了吗?

14. 检查预训练模型的预处理

15. 检查训练/验证/测试集的预处理

4.实现问题

16. 试着解决这个问题的简单版本

17. “随机”寻找正确的损失

18. 检查损失函数

19. 验证损失输入

20.调整损失权重

21. 监视其他指标

22. 测试任何自定义层

23. 检查“冻结”层或变量

24. 增加网络的大小

25. 检查隐藏的维度错误

26. 进行梯度检查

更多信息可参阅:

http://ufldl.stanford.edu/tutorial/supervised/DebuggingGradientChecking http://cs231n.github.io/neural-networks-3/#gradcheck https://www.coursera.org/lecture/machine-learning/gradient-checking-Y3s6r

5.训练问题

27. 解决一个非常小的数据集

28. 检查权重初始化

29. 更改超参数

30.减少正规化

31. 给它时间

32. 从训练模式切换到测试模式

33. 可视化训练

“对于权重,这些直方图应该在一段时间后具有近似高斯(正态)分布。对于偏差,这些直方图通常从0开始,并且通常以近似高斯分布结束(LSTM是一个例外)。注意那些发散到+/-∞的参数。注意那些非常大的偏移量。如果类别的分布非常不平衡,有时可能会在输出层中进行分类。”

34. 尝试不同的优化器

http://ruder.io/optimizing-gradient-descent/

35. 爆炸/消失的梯度

36. 升高/降低学习率

37. 克服NaN

降低学习速度,特别是如果你在前100次迭代中得到了NaNs。

NaNs可以由除以0,或0或负数的自然对数产生。

Russell Stewart在如何应对NaN中有很好的建议。

http://get.mysecurify.com/view/item_81593.html

试着一层一层地评估你的网络,看看NaNs出现在哪里。

◆

精彩推荐

◆

推荐阅读

100多次竞赛后,他研发了一个几乎可以解决所有机器学习问题的框架

王霸之路:从0.1到2.0,一文看尽TensorFlow“奋斗史”

伯克利人工智能研究院开源深度学习数据压缩方法Bit-Swap,性能创新高

NLP被英语统治?打破成见,英语不应是「自然语言」同义词

TensorFlow2.0正式版发布,极简安装TF2.0(CPU&GPU)教程

肖仰华:知识图谱构建的三要素、三原则和九大策略 | AI ProCon 2019

AI落地遭“卡脖子”困境:为什么说联邦学习是解决良方?

10分钟搭建你的第一个图像识别模型 | 附完整代码

限时早鸟票 | 2019 中国大数据技术大会(BDTC)超豪华盛宴抢先看!

你点的每个“在看”,我都认真当成了喜欢

相关文章:

菜鸟Vue学习笔记(三)

菜鸟Vue学习笔记(三)本周使用了Vue来操作表单,接下来说下Vue中双向绑定表单元素的用法。Vue中双向绑定是使用的v-model,所谓的双向绑定即改变变量的值,表单元素的值也会改变,同样的,改变表单元素…

Python中的注释(转)

一、单行注释单行注释以#开头,例如:print 6 #输出6二、多行注释(Python的注释只有针对于单行的注释(用#),这是一种变通的方法)多行注释用三引号将注释括起来,例如:多行注释多行注释三…

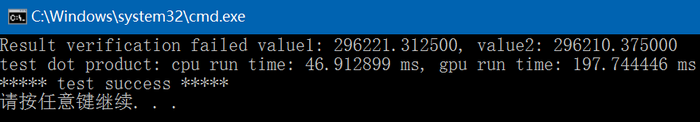

CUDA Samples: dot product(使用零拷贝内存)

以下CUDA sample是分别用C和CUDA实现的点积运算code,CUDA包括普通实现和采用零拷贝内存实现两种,并对其中使用到的CUDA函数进行了解说,code参考了《GPU高性能编程CUDA实战》一书的第十一章,各个文件内容如下:funset.cp…

一文读懂线性回归、岭回归和Lasso回归

(图片由AI科技大本营付费下载自视觉中国)作者 | 文杰编辑 | yuquanle本文介绍线性回归模型,从梯度下降和最小二乘的角度来求解线性回归问题,以概率的方式解释了线性回归为什么采用平方损失,然后介绍了线性回归中常用的…

tf.matmul / tf.multiply

import tensorflow as tfimport numpy as np 1.tf.placeholder placeholder()函数是在神经网络构建graph的时候在模型中的占位,此时并没有把要输入的数据传入模型,它只会分配必要的内存。 等建立session,在会话中,运行模型的时候通…

Java 匿名类也能使用构造函数

为什么80%的码农都做不了架构师?>>> 匿名类虽然没有名字,但可以有一个初始化块来充当构造函数。 public enum Ops {ADD, SUB} public class Calculator { private int i, j, result; public Calculator() {} public Calculator(int _i, …

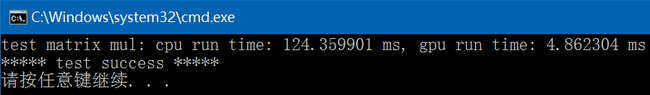

CUDA Samples: matrix multiplication(C = A * B)

以下CUDA sample是分别用C和CUDA实现的两矩阵相乘运算code即C A*B,CUDA中包含了两种核函数的实现方法,第一种方法来自于CUDA Samples\v8.0\0_Simple\matrixMul,第二种采用普通的方法实现,第一种方法较快,但有些复杂&am…

业界首个实时多目标跟踪系统开源

(图片由AI科技大本营付费下载自视觉中国)作者 | CV君来源 | 我爱计算机视觉(ID:aicvml)相对业界研究比较多的单目标跟踪,多目标跟踪(Multi-Object Tracking,MOT)系统在实…

python基础 练习题

【练习题1】实现一个整数加法计算器如 content input(">>> ") # 59 , 64 count0 while 1:contentinput(>>>)s1 content.split()print(s1)count 0for i in s1:count int(i)print(count) 【练习题2】请编写1 - 100 所有数的和 sum0 for i in r…

[再寄小读者之数学篇](2014-04-18 from 352558840@qq.com [南开大学 2014 年高等代数考研试题]二次型的零点)...

(2014-04-18 from 352558840qq.com [南开大学 2014 年高等代数考研试题]) 设 ${\bf A}$ 为实对称矩阵, 存在线性无关的向量 ${\bf x}_1,{\bf x}_2$, 使得 ${\bf x}_1^T{\bf A}{\bf x}_1>0$, ${\bf x}_2^T{\bf A}{\bf x}_2<0$. 证明: 存在线性无关的向量 ${\bf x}_3,{\bf …

从0到1详解推荐系统中的嵌入方法,原理、算法到应用都讲明白了

(图片由AI科技大本营付费下载自视觉中国)作者丨gongyouliu编辑丨lily来源 | 大数据与人工智能(ID:)前言作者曾在这篇文章中提到,矩阵分解算法是一类嵌入方法,通过将用户行为矩阵分解为用户特征矩…

iOS-Swift中的递增(++)和递减(--)被取消的原因-官方答复

众所周知,在很多编程语言中,对一个变量递增1用,递减1用--,在Swift3之前也是可以这么用的,但之后被取消了。 所以在目前Swift5的版本中,只能用1和-1来进行递增和递减了 如果坚持用或--将会提示以下错误&…

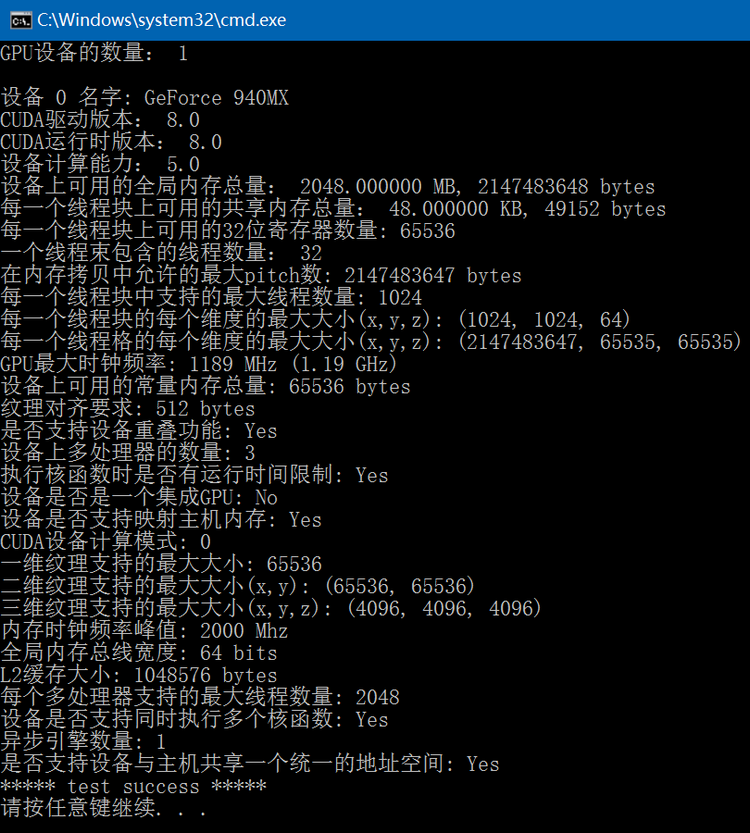

CUDA Samples: 获取设备属性信息

通过调用CUDA的cudaGetDeviceProperties函数可以获得指定设备的相关信息,此函数会根据GPU显卡和CUDA版本的不同得到的结果也有所差异,下面code列出了经常用到的设备信息:#include "funset.hpp" #include <iostream> #include…

apache代理模块proxy使用

1、安装proxy模块[rootlocalhost modules]# cd /usr/local/src/httpd-2.2.16 [rootlocalhost httpd-2.2.16]# cd modules [rootlocalhost modules]# ls aaa config5.m4 debug filters ldap Makefile.in NWGNUmakefile ssl arch database echo …

CUDA Samples: image normalize(mean/standard deviation)

以下CUDA sample是分别用C和CUDA实现的通过均值和标准差对图像进行类似归一化的操作,并对其中使用到的CUDA函数进行了解说,各个文件内容如下:关于均值和标准差的计算公式可参考: http://blog.csdn.net/fengbingchun/article/detai…

中文预训练ALBERT模型来了:小模型登顶GLUE,Base版模型小10倍、速度快1倍

(图片由AI科技大本营付费下载自视觉中国)作者 | 徐亮(实在智能算法专家) 来源 | AINLP(ID:nlpjob)谷歌ALBERT论文刚刚出炉一周,中文预训练ALBERT模型来了,感兴趣的同学可以直接尝鲜试…

树莓派安装go

简介 大学的时候在使用openfalcon的时候讲过这个东西,但是那时候是介绍open-falcon的,所以感觉不是很具体,所以今天在安装frp的时候也碰到了这个问题,我就具体的说下 安装go1.4 编译最新版本的go的时候一定要先编译安装go1.4&…

设计模式中的原则

设计模式(详情click)这个术语是由Erich Gamma等人在1990年代从建筑设计领域引入到计算机科学的。它是对软件设计中普遍存在(反复出现)的各种问题,所提出的解决方案。 设计模式并不直接用来完成代码的编写,而是描述在各种不同情况下…

CUDA Samples: approximate image reverse

以下CUDA sample是分别用C和CUDA实现的对图像进行某种类似reverse的操作,并对其中使用到的CUDA函数进行了解说,各个文件内容如下:common.hpp:#ifndef FBC_CUDA_TEST_COMMON_HPP_ #define FBC_CUDA_TEST_COMMON_HPP_#include<random> #i…

超详细支持向量机知识点,面试官会问的都在这里了

(图片付费下载自视觉中国)作者 | 韦伟来源 | 知乎导语:持续准备面试中,准备的过程中,慢慢发现,如果死记硬背的话很难,可当推导一遍并且细细研究里面的缘由的话,面试起来应该什么都不…

vue-router点击切换路由报错

报错: 报错原因: 设置mode:history解决方法: 将router的mode设置为‘hash就不报错了 原因下次再分析?

gvim配置相关

用 vundle 来管理 vim 插件(包含配置文件vimrc和gvimrc) gvim插件管理神器:vundle的安装与使用 Vim插件管理Vundle Linux 下VIM的配置 Vim配置系列(一) ---- 插件管理 Vim配置系列(二) —- 好看的statusline vim优秀插件整理 一些有用的 VIM …

深度学习有哪些接地气又好玩的应用?

过去几年中,深度学习中的很多技术如计算机视觉、自然语言处理等被应用在很多实际问题中,而且相关成果也表明深度学习能让人们的工作效果比以前更好。我们收集了一些深度学习方面的创意应用,虽然没有对每项应用进行详尽描述,但是希…

Ubuntu下通过CMake文件编译CUDA+OpenCV代码操作步骤

在 CUDA_Test 工程中,CUDA测试代码之前仅支持在Windows10 VS2013编译,今天在Ubuntu 14.04下写了一个CMakeLists.txt文件,支持在Linux下也可以通过CMake编译CUDA_Test工程,CMakeLists.txt文件内容如下:# CMake file f…

JAVA 多用户商城系统b2b2c-Spring Cloud常见问题与总结(一)

在使用Spring Cloud的过程中,难免会遇到一些问题。所以对Spring Cloud的常用问题做一些总结。需要JAVA Spring Cloud大型企业分布式微服务云构建的B2B2C电子商务平台源码 一零三八七七四六二六 一、Eureka常见问题 1.1 Eureka 注册服务慢 默认情况下,服务…

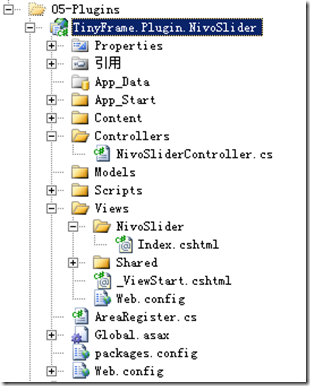

TinyFrame升级之八:实现简易插件化开发

本章主要讲解如何为框架新增插件化开发功能。 在.net 4.0中,我们可以在Application开始之前,通过PreApplicationStartMethod方法加载所需要的任何东西。那么今天我们主要做的工作就集中在这个时间段: 1.将插件DLL及文件拷贝入主网站目录并编译…

快手王华彦:端上视觉技术的极致效率及其短视频应用实践 | AI ProCon 2019

演讲嘉宾 | 王华彦(快手硅谷Y-tech实验室负责人) 编辑 | Just 出品 | AI科技大本营(ID:rgznai100) 快手用户日均上传1500万个视频,要把这些作品准确的分发给超2亿活跃用户,如果没有强大的AI技术系统去理解…

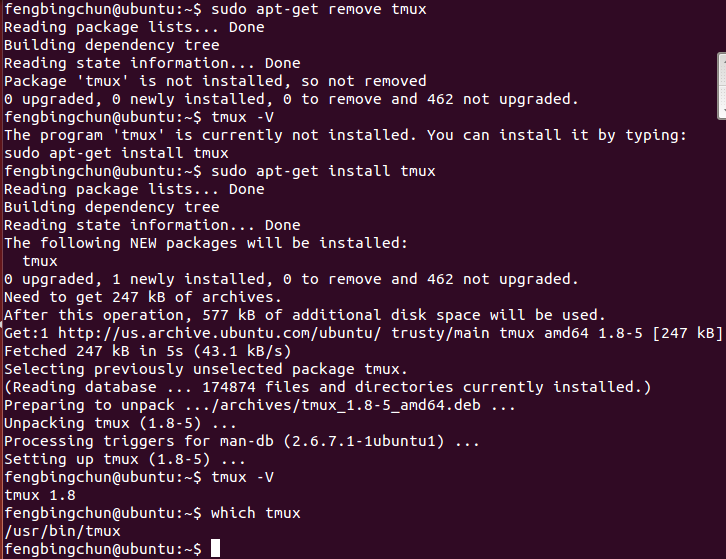

tmux简介及安装

tmux是一个开源工具,用于在一个终端窗口中运行多个终端会话。它可以减少过多的打开终端控制台。tmux的源码在 https://github.com/tmux/tmux ,它的License是BSD。tmux可以直接通过sudo apt-get install tmux命令安装(通过sudo apt-get remove tmux移除)…

Swift中依赖注入的解耦策略

原文地址:Dependency Injection Strategies in Swift 简书地址:Swift中依赖注入的解耦策略 今天我们将深入研究Swift中的依赖注入,这是软件开发中最重要的技术之一,也是许多编程语言中使用频繁的概念。 具体来说,我们将…

Eclipse mac 下的快捷键

2019独角兽企业重金招聘Python工程师标准>>> Eclipse,MyEclipse 的preference 在“windows”下边,mac下在左上角苹果图标边上 win下我们都习惯了ctrl c,在Mac 下使用标准键盘变成了win键c 系统的偏好设定 -> 键盘 -> 修饰…