讲解光流估计 liteflownet3

目录

讲解光流估计 LiteFlowNet3

光流估计是计算机视觉领域的重要任务,其可以估计图像序列中每个像素的运动矢量。光流估计在许多应用中都有广泛的应用,例如视频压缩、运动分析和场景理解等。LiteFlowNet3 是一个轻量级的光流估计模型,本文将对其进行详细讲解。

什么是 LiteFlowNet3

LiteFlowNet3 是光流估计模型 LiteFlowNet 的最新版本。它采用了轻量级的网络结构,具有较小的模型参数和计算复杂度,同时具备较高的计算效率和准确性。LiteFlowNet3 的设计目标是在保持较小模型尺寸的同时,提供与传统光流估计算法相当甚至更好的性能。

模型架构

LiteFlowNet3 采用了编码器-解码器(Encoder-Decoder)结构,其中编码器用于提取输入图像的特征,解码器则用于生成光流估计结果。 具体而言,编码器使用了轻量级的卷积神经网络,通过多个卷积和池化层来逐级提取图像的特征。解码器则是一个逐级反卷积和上采样的过程,将编码器提取的特征进行逐步恢复和细化,最终生成光流估计的结果。为了增加模型的感受野和提高特征表达能力,LiteFlowNet3 还引入了残差连接和金字塔结构等优化技术。

训练与优化

LiteFlowNet3 的训练过程包括两个阶段:预训练和微调训练。 在预训练阶段,大规模的合成数据集被用于训练模型。合成数据集可以通过渲染物体模型并生成相应的运动序列来获得。预训练旨在使模型学习到光流的基本属性,如运动边界和局部一致性。 在微调训练阶段,使用真实的光流估计数据集对模型进行微调。微调的目的是调整模型以适应真实场景中的光流估计任务。 为了进一步提高模型的性能,LiteFlowNet3 还采用了不同的优化技术,如灰度图像金字塔和金字塔的级联,以及弱监督学习等。

应用与展望

LiteFlowNet3 具有较小的模型尺寸和较高的计算效率,因此在计算资源受限的设备上可以灵活应用。该模型在光流估计任务上表现出色,能够处理不同类型的视频数据,并且在速度和准确性之间取得了良好的平衡。 未来,随着计算能力的不断提高和模型设计的进一步优化,我们可以期待更多高效而精确的光流估计模型的出现。LiteFlowNet3 作为其中的一种典型代表,为我们提供了一种轻量级的光流估计解决方案,为计算机视觉领域的应用带来了更多的可能性。

以下是一个示例代码,演示如何使用LiteFlowNet3进行光流估计:

pythonCopy code

import cv2

import numpy as np

import torch

from torchvision.transforms import ToTensor

# 加载LiteFlowNet3模型

model = torch.hub.load('nianticlabs/monodepth2', 'LiteFlowNet')

# 加载图像序列

image1 = cv2.imread('image1.jpg')

image2 = cv2.imread('image2.jpg')

# 图像预处理

preprocess = ToTensor()

# 将图像转换为张量

input1 = preprocess(image1).unsqueeze(0).cuda()

input2 = preprocess(image2).unsqueeze(0).cuda()

# 模型推断

with torch.no_grad():

flow = model(input1, input2)

# 将光流张量转换为Numpy数组

flow = flow.squeeze().cpu().numpy()

# 可视化光流结果

h, w, _ = flow.shape

fx, fy = np.meshgrid(range(w), range(h))

u, v = flow[:, :, 0], flow[:, :, 1]

plt.figure()

plt.imshow(image1[..., ::-1]) # 显示第一张图像

plt.quiver(fx, fy, u, v, color='r', units='dots') # 显示光流向量

plt.show()

# 保存光流向量作为图像

cv2.imwrite('flow.jpg', flow)上述代码假设已经安装了必要的库(如OpenCV、torch和torchvision),并且已经下载了LiteFlowNet3模型。代码首先加载模型,然后加载两个连续的图像作为输入。接下来,图像经过预处理后转换为张量,并通过模型进行推断得到光流结果。最后,可以可视化光流结果并保存光流向量作为图像。

LiteFlowNet3是一个轻量级的光流估计模型,它具有一些缺点和类似的模型可供参考。 缺点:

- 较低的精度:由于LiteFlowNet3是一个轻量级模型,它在光流估计任务上的精度相对较低。与更复杂的光流估计模型相比,LiteFlowNet3在处理复杂场景或运动模糊等情况下可能会产生不准确的光流结果。

- 速度较慢:相对于一些更简单的光流估计算法,LiteFlowNet3的计算速度较慢。尽管它是一种轻量级模型,但由于其网络结构的复杂性,它可能在某些场景下需要更长的推断时间。 类似的模型:

- PWC-Net:PWC-Net是一种用于光流估计的双向卷积神经网络模型,与LiteFlowNet3相比,PWC-Net具有更高的精度,并且在处理复杂场景和运动模糊时表现更好。然而,PWC-Net相对于LiteFlowNet3来说更复杂和资源密集,因此在某些嵌入式设备或实时应用中可能不太适用。

- SpyNet:SpyNet是一种基于卷积神经网络的光流估计模型,它具有较低的计算复杂性,适用于实时应用。虽然SpyNet的精度相对较低,但它在速度和轻量级方面具有优势。SpyNet可以在较短的时间内生成光流结果,适用于一些对实时性要求较高的应用场景。 这些是LiteFlowNet3的一些缺点和类似的模型。在选择光流估计模型时,需要根据具体应用场景的需求来确定最适合的模型。

结论

本文对光流估计模型 LiteFlowNet3 进行了详细的讲解。我们介绍了 LiteFlowNet3 的模型架构、训练和优化方法,以及其在计算机视觉应用中的潜在应用。LiteFlowNet3 作为一个轻量级的光流估计模型,为光流估计任务提供了一种高效而准确的解决方案。

相关文章:

Yolov11-detect训练自己的数据集

至此,整个YOLOv11的训练预测阶段完成,与YOLOv8差不多。欢迎各位批评指正。

YOLOv10训练自己的数据集

至此,整个YOLOv10的训练预测阶段完成,与YOLOv8差不多。欢迎各位批评指正。

YOLOv10环境搭建、模型预测和ONNX推理

运行后会在文件yolov10s.pt存放路径下生成一个的yolov10s.onnxONNX模型文件。安装完成之后,我们简单执行下推理命令测试下效果,默认读取。终端,进入base环境,创建新环境。(1)onnx模型转换。

YOLOv7-Pose 姿态估计-环境搭建和推理

终端,进入base环境,创建新环境,我这里创建的是p38t17(python3.8,pytorch1.7)安装pytorch:(网络环境比较差时,耗时会比较长)下载好后打开yolov7-pose源码包。imgpath:需要预测的图片的存放路径。modelpath:模型的存放路径。Yolov7-pose权重下载。打开工程后,进入设置。

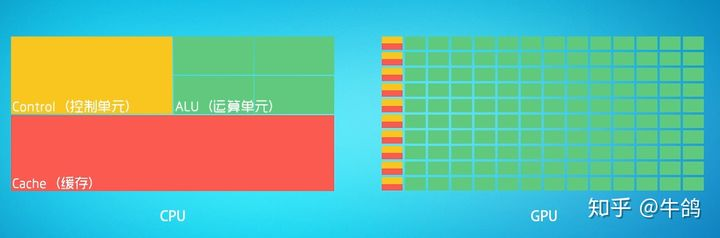

深度学习硬件基础:CPU与GPU

CPU:叫做中央处理器(central processing unit)作为计算机系统的运算和控制核心,是信息处理、程序运行的最终执行单元。[^3]可以形象的理解为有25%的ALU(运算单元)、有25%的Control(控制单元)、50%的Cache(缓存单元)GPU:叫做图形处理器。

YOLOv8-Detect训练CoCo数据集+自己的数据集

至此,整个训练预测阶段完成。此过程同样可以在linux系统上进行,在数据准备过程中需要仔细,保证最后得到的数据准确,最好是用显卡进行训练。有问题评论区见!

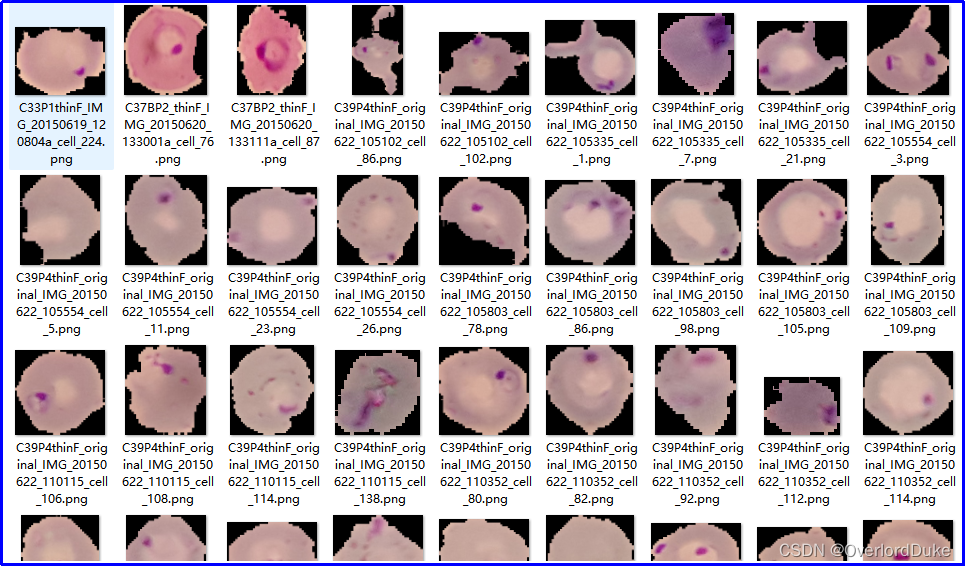

基于深度学习的细胞感染性识别与判定

通过引入深度学习技术,我们能够更精准地识别细胞是否受到感染,为医生提供更及时的信息,有助于制定更有效的治疗方案。基于深度学习的方法通过学习大量样本,能够自动提取特征并进行准确的感染性判定,为医学研究提供了更高效和可靠的手段。通过引入先进的深度学习技术,我们能够实现更快速、准确的感染性判定,为医学研究和临床实践提供更为可靠的工具。其准确性和效率将为医学研究带来新的突破,为疾病的早期诊断和治疗提供更可靠的支持。通过大规模的训练,模型能够学到细胞感染的特征,并在未知数据上做出准确的预测。

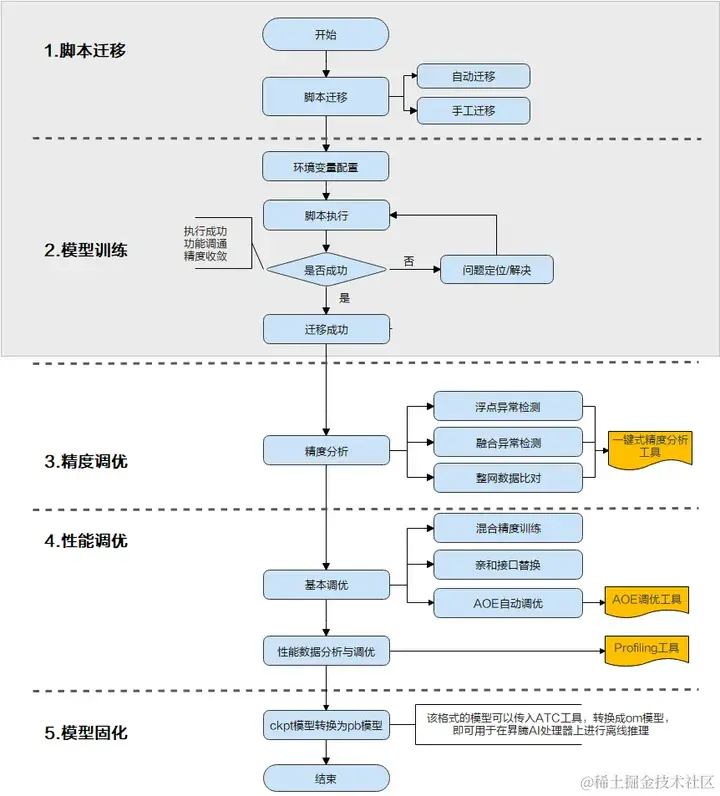

一文详解TensorFlow模型迁移及模型训练实操步骤

当前业界很多训练脚本是基于TensorFlow的Python API进行开发的,默认运行在CPU/GPU/TPU上,为了使这些脚本能够利用昇腾AI处理器的强大算力执行训练,需要对TensorFlow的训练脚本进行迁移。

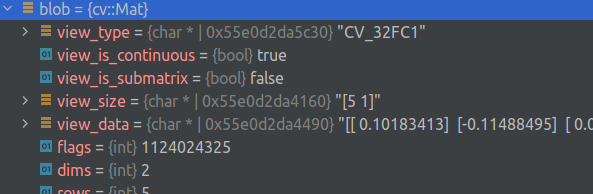

将 OpenCV 与 gdb 驱动的 IDE 结合使用

能力这个漂亮的打印机可以显示元素类型、标志和(可能被截断的)矩阵。众所周知,它可以在 Clion、VS Code 和 gdb 中工作。Clion 示例安装移入 .放在方便的地方,重命名并移动到您的个人文件夹中。将“source”行更改为指向您的路径。如果系统中安装的 python 3 版本与 gdb 中的版本不匹配,请使用完全相同的版本创建一个新的虚拟环境,相应地安装并更改 python3 的路径。用法调试器中以前缀为前缀的字段是为方便起见而添加的伪字段,其余字段保持原样。

机器视觉技能培养:桥接学院与工业界的鸿沟

在当前的教育体系中,大学生往往缺乏直接参与机器视觉工作的机会。本文将探讨机器视觉学习的重要性,分析技术指导和实践项目的必要性。并提出一个全面的机器视觉学习路线图。

PyTorch中nn.Module的继承类中方法foward是自动执行的么?

在 PyTorch的 nn.Module中,forward方法并不是自动执行的,但它是在模型进行前向传播时必须调用的一个方法。当你实例化一个继承自torch.nn.Module的自定义类并传入输入数据时,需要通过调用该实例来实现前向传播计算,这实际上会隐式地调用forward方法。

神经网络中的分位数回归和分位数损失

分位数回归是一种强大的统计工具,对于那些关注数据分布中不同区域的问题,以及需要更加灵活建模的情况,都是一种有价值的方法。本文将介绍了在神经网络种自定义损失实现分位数回归,并且介绍了如何检测和缓解预测结果的"扁平化"问题。Quantile loss在一些应用中很有用,特别是在金融领域的风险管理问题中,因为它提供了一个在不同分位数下评估模型性能的方法。作者:Shiro Matsumoto。

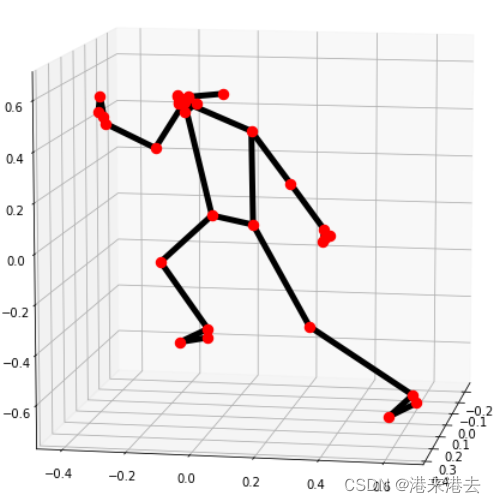

Mediapipe绘制实时3d铰接骨架图——Mediapipe实时姿态估计

使用Mediapipe绘制实时3d骨架铰接图;使用Mediapipe、matplotlib进行3d姿态估计、绘制实时3d坐标

基于神经网络——鸢尾花识别(Iris)

鸢尾花识别是学习AI入门的案例,这里和大家分享下使用Tensorflow2框架,编写程序,获取鸢尾花数据,搭建神经网络,最后训练和识别鸢尾花。

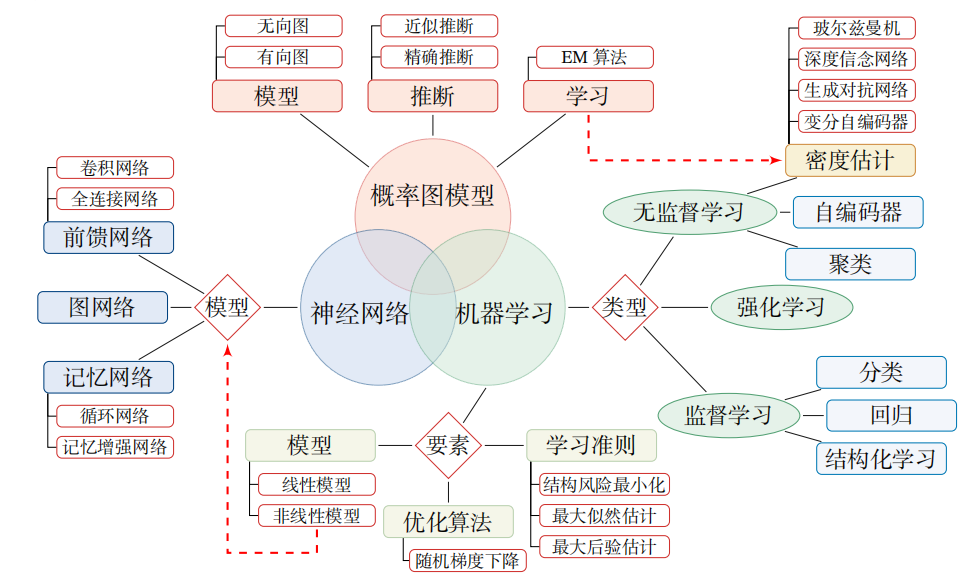

深度学习知识点全面总结

深度学习定义:一般是指通过训练多层网络结构对未知数据进行分类或回归深度学习分类:有监督学习方法——深度前馈网络、卷积神经网络、循环神经网络等; 无监督学习方法——深度信念网、深度玻尔兹曼机,深度自编码器等。深度神经网络的基本思想是通过构建多层网络,对目标进行多层表示,以期通过多层的高层次特征来表示数据的抽象语义信息,获得更好的特征鲁棒性。神经网络的计算主要有两种:前向传播(foward propagation, FP)作用于每一层的输入,通过逐层计算得到输出结果;

为什么深度学习神经网络可以学习任何东西

尽管如此,神经网络在处理一些对计算机而言极具挑战性的任务上表现出色,特别是在需要直觉和模糊逻辑的领域,如计算机视觉和自然语言处理,神经网络已经彻底改变了这些领域的面貌。在探讨神经网络如何学习的过程中,我们首先遇到了一个基本问题:如果我们不完全知道一个函数的形式,只知道它的部分输入和输出值,我们能否对这个函数进行逆向工程?重要的是,只要知道了这个函数,就可以针对任意输入x计算出对应的输出y。一种简单而有力的思考世界的方式,通过结合简单的计算,我们可以让计算机构造任何我们想要的功能,神经网络,从本质上讲,

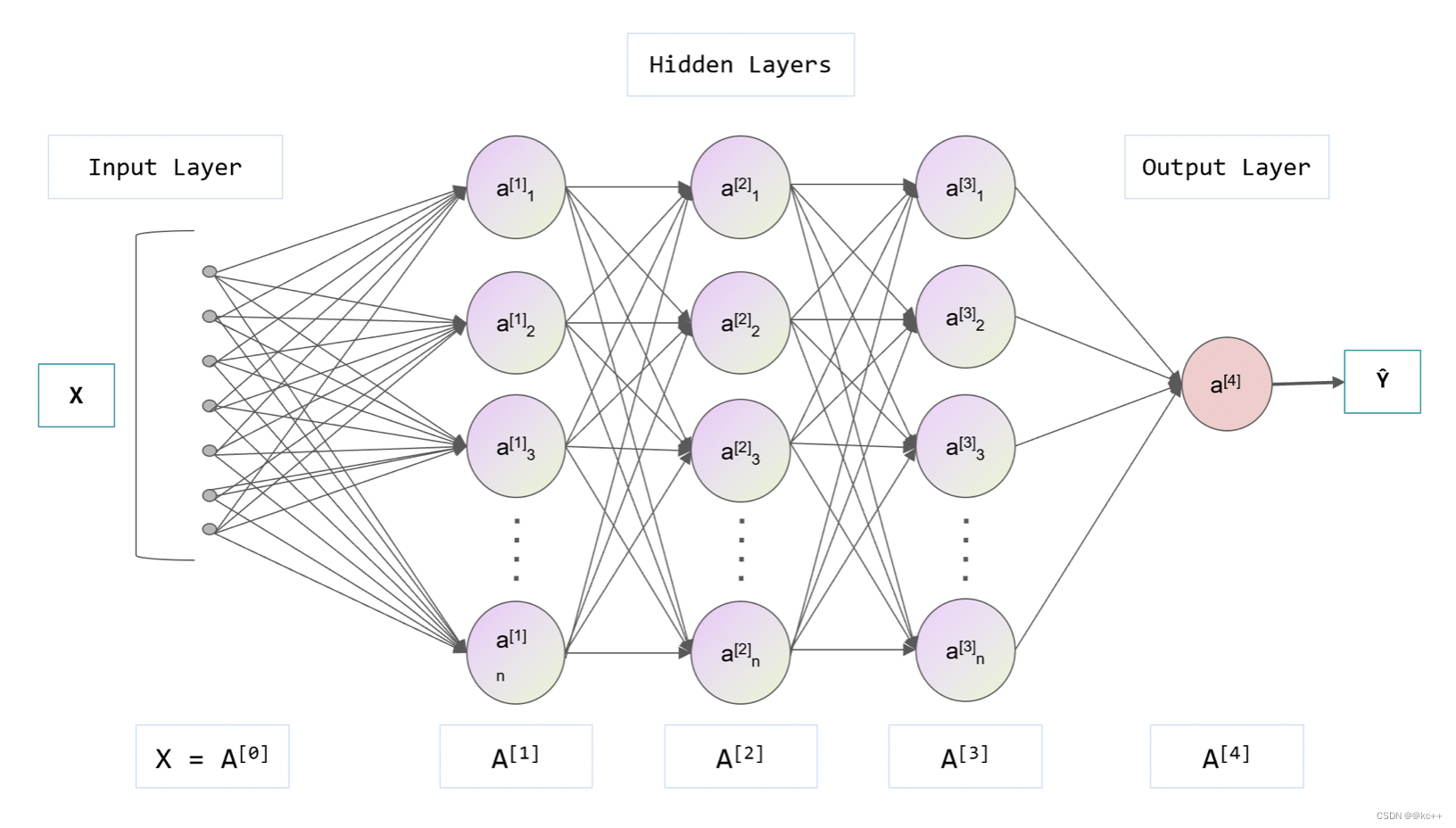

深度学习与神经网络

神经网络是一种模拟人脑神经元行为的计算模型,神经网络由大量的神经元(在计算领域中常被称为“节点”或“单元”)组成,并且这些神经元被分为不同的层,分别为输入层、隐藏层和输出层。每一个神经元都与前一层的所有神经元相连接,连接的强度(或权重)代表了该连接的重要性。神经元接收前一层神经元的信息(这些信息经过权重加权),然后通过激活函数(如Sigmoid、ReLU等)处理,将结果传递到下一层。输入层接收原始数据,隐藏层负责处理这些数据,而输出层则将处理后的结果输出。

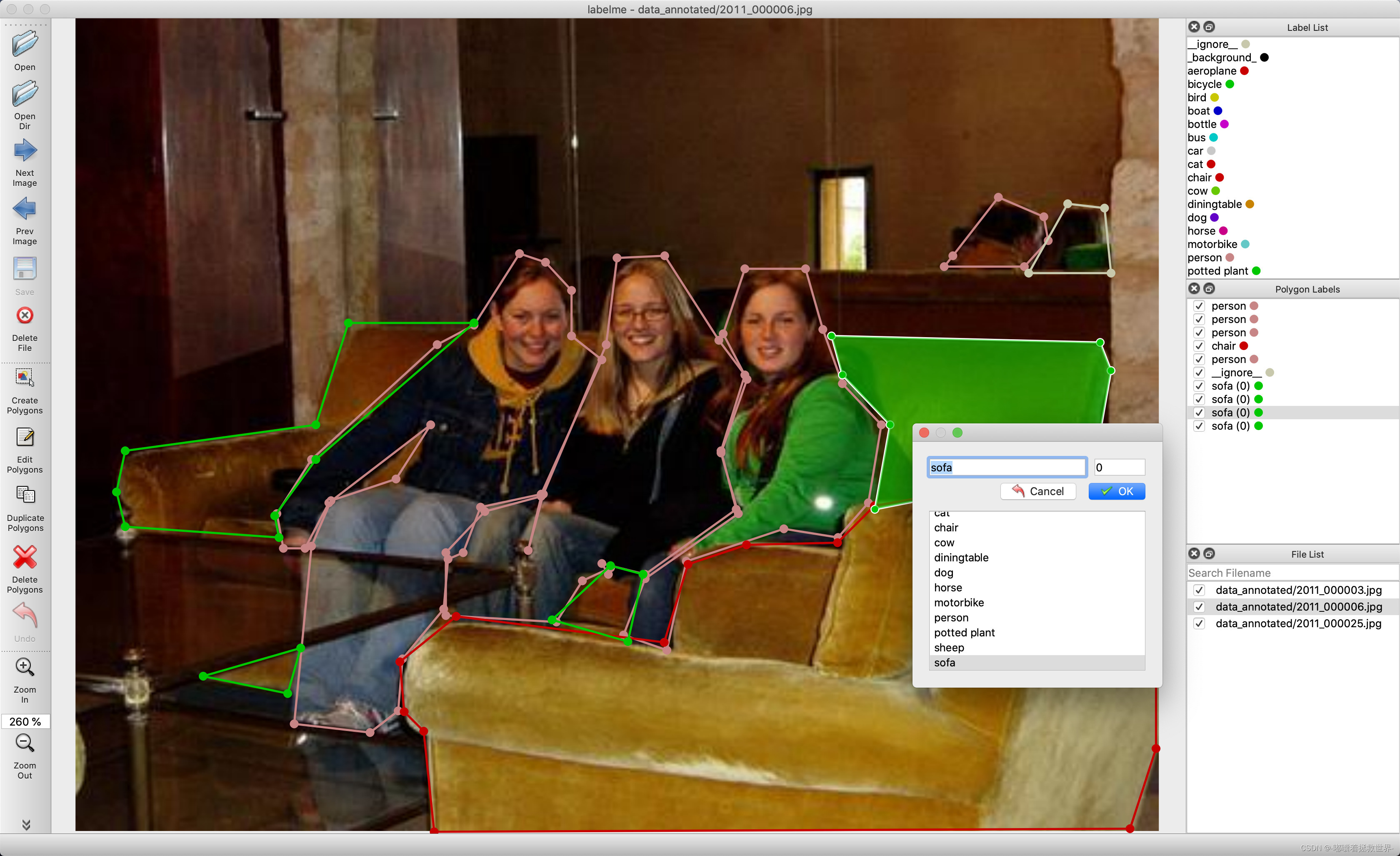

labelme安装与使用教程(内附一键运行包和转格式代码)

Labelme是一个开源的图像标注工具,由麻省理工学院的计算机科学和人工智能实验室(CSAIL)开发。它主要用于创建计算机视觉和机器学习应用所需的标记数据集。LabelMe让用户可以在图片上标注对象和区域,为机器学习模型提供训练数据。它支持多种标注类型,如矩形框、多边形和线条等。它是用 Python 编写的,并使用 Qt 作为其图形界面。

讲解opencv检测黑色区域

本文介绍了使用OpenCV检测黑色区域的两种方法:阈值方法和颜色范围方法。阈值方法通过将图像转换为灰度图像并应用阈值处理来检测黑色区域。颜色范围方法通过在RGB或HSV颜色空间中定义合适的颜色范围来检测黑色区域。这些方法对于图像处理、目标定位和计算机视觉任务都非常有用。当用OpenCV检测黑色区域的一个实际应用场景是汽车驾驶辅助系统中的车道检测。import cv2# 转换为灰度图像# 应用阈值处理# 查找车道线轮廓# 找出最长的轮廓(假设为车道线)# 拟合多项式曲线。

讲解cv2‘ has no attribute ‘gapi_wip_gst_GStreamerPipeline‘错误解决方法

在使用OpenCV库中的cv2模块进行图像处理时,遇到"cv2 'has no attribute 'gapi_wip_gst_GStreamerPipeline'"错误提示可能是由于OpenCV库版本问题或者代码错误导致的。更新OpenCV库到最新版本。检查并修改代码,确保正确导入cv2模块和正确使用相关函数或类。尝试使用其他cv2库的功能替代。希望本文对解决"cv2 'has no attribute 'gapi_wip_gst_GStreamerPipeline'"错误问题有所帮助。

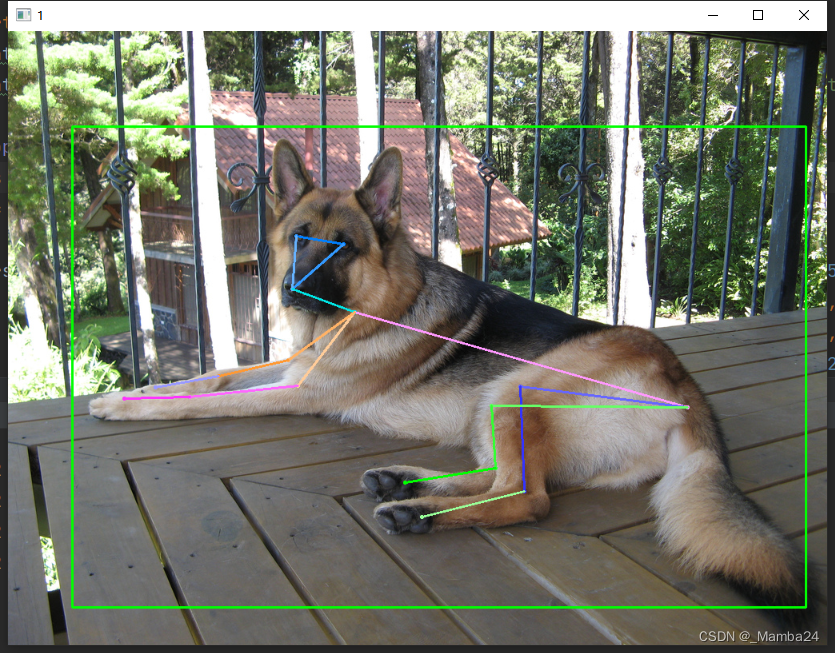

将AP-10K数据集Json格式转成Yolov8-Pose姿态的txt格式

class-index>是对象的类的索引,<x> <y> <width> <height>是边界框的坐标,<px1> <py1> <px2> <py2> ... <pxn> <pyn>是关键点的像素坐标。这样就将AP-10K数据集Json格式转成Yolov8-Pose的txt格式了。将txt的信息可视化在图片上进行验证。检查生成的txt是否准确。

讲解python 图像数据类型及颜色空间转换

通过上述示例代码,我们可以将彩色图像转换为HSV颜色空间,并设置红色目标区域的颜色范围。颜色空间转换是一种将一种颜色表示方式转换为另一种颜色表示方式的过程。不同的颜色空间在表示颜色和对颜色的处理上有各自的特点和优势。本文介绍了Python中的常见图像数据类型以及灰度化、RGB到HSV转换和颜色阈值分割等常见颜色空间转换。本文将深入探讨Python中的图像数据类型,以及如何进行常见的颜色空间转换。颜色空间转换是图像处理中常见的操作之一。根据具体的需求,你可以使用不同的库和方法来进行更复杂的颜色空间转换。

讲解nvcc fatal : A single input file is required for a non-link phase when an outputfile is specified

在使用nvcc编译和链接CUDA代码的过程中,要避免"nvcc fatal: A single input file is required for a non-link phase when an output file is specified"错误,你需要明确指定编译阶段和链接阶段的输入文件,并将它们分别与相关选项放在一起。这样做可以确保nvcc命令正确处理你的代码,并生成所需的输出文件。希望本文能够帮助你解决这个常见的错误,并更顺利地进行CUDA开发和GPU加速编程。

讲解异常: cv::Exception,位于内存位置 0x00000059E67CE590 处

在使用OpenCV进行图像处理和计算机视觉任务时,异常是一种常见的异常情况,通常由于内存分配失败引起。在解决该异常时,我们应该考虑增加系统可用内存、优化算法和数据集,以及检查代码中的内存管理问题。通过这些方法,我们可以更好地处理异常,提高系统的稳定性和性能。希望本文能够帮助您理解和解决异常,并顺利进行OpenCV图像处理和计算机视觉任务。

讲解OpenCV对图像的光照归一化处理

光照归一化是图像处理中重要的预处理步骤之一,可以提高图像可视性和分析结果。在OpenCV中,我们可以使用直方图均衡化和自适应直方图均衡化这两种方法来实现光照归一化处理。希望通过本文的介绍,读者对OpenCV中的光照归一化处理有更深入的理解,并能在实际应用中灵活运用。如果你对OpenCV的图像处理还有更多兴趣,建议阅读OpenCV官方文档和相关教程,进一步探索其丰富功能和应用场景。

讲解Unsupported gpu architecture ‘compute_*‘2017解决方法

在使用2017年以前的NVIDIA GPU进行深度学习训练时,经常会遇到"Unsupported GPU Architecture 'compute_*'"的错误。本篇文章将介绍该错误的原因并提供解决方法。

YOLOv8-Pose训练自己的数据集

至此,整个YOLOv8-Pose模型训练预测阶段完成。此过程同样可以在linux系统上进行,在数据准备过程中需要仔细,保证最后得到的数据准确,最好是用显卡进行训练。有问题评论区见!

解决方案:avcodec_receive_packet AVERROR(EAGAIN)

FFmpeg是一个开源的跨平台音视频处理工具集,它由一个主命令行工具和一组库组成,提供了音视频编解码、格式转换、流媒体处理、音视频过滤、音视频录制和播放等功能。错误,我们将继续循环,直到获取到一个有效的数据包或遇到其他错误。同时,根据实际情况,调整解码器的缓冲区大小也可能有助于提高解码性能和减少错误发生的频率。然后,我们获取音频解码器并创建解码器上下文,并进行解码器的初始化。错误,并在实际应用场景中对解码后的音频数据包进行处理和分析。你可以根据自己的需求,进一步扩展和定制代码。,如果是的话,我们继续循环。

讲解from .pycaffe import Net, SGDSolver, NesterovSolver, AdaGradSolver, RMSPropSolver, AdaDeltaSolver,

相比于AdaGrad,AdaDelta算法进一步减少了学习率震荡的问题,并提供了更平稳的优化过程。以上六个模块在Caffe中发挥着重要的作用,为深度学习模型的训练和优化提供了基础支持。通过合理选择和配置这些模块,我们可以根据具体任务和模型需求进行高效的训练和推理。它是一种自适应学习率方法,通过使用梯度平方的滑动平均值来调整每个参数的学习率。如果你对Caffe框架、深度学习模型训练有进一步的兴趣,建议你阅读Caffe的官方文档和资源,深入学习和探索。模块,我们可以创建和操控神经网络,从而进行模型训练和推理。

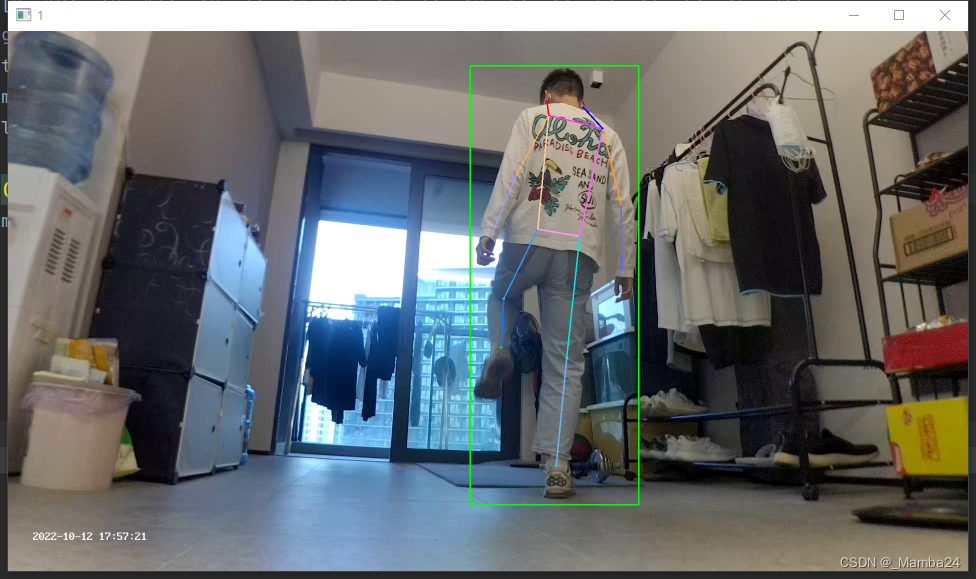

将labelme标注的人体姿态Json文件转成训练Yolov8-Pose的txt格式

最近在训练Yolov8-Pose时遇到一个问题,就是如何将自己使用labelme标注的Json文件转化成可用于Yolov8-Pose训练的txt文件。