MapReduce编程初体验

需求:在给定的文本文件中统计输出每一个单词出现的总次数

第一步: 准备一个aaa.txt文本文档

第二步: 在文本文档中随便写入一些测试数据,这里我写入的是

hello,world,hadoop

hello,hive,sqoop,flume

kitty,tom,jerry,world

hadoop

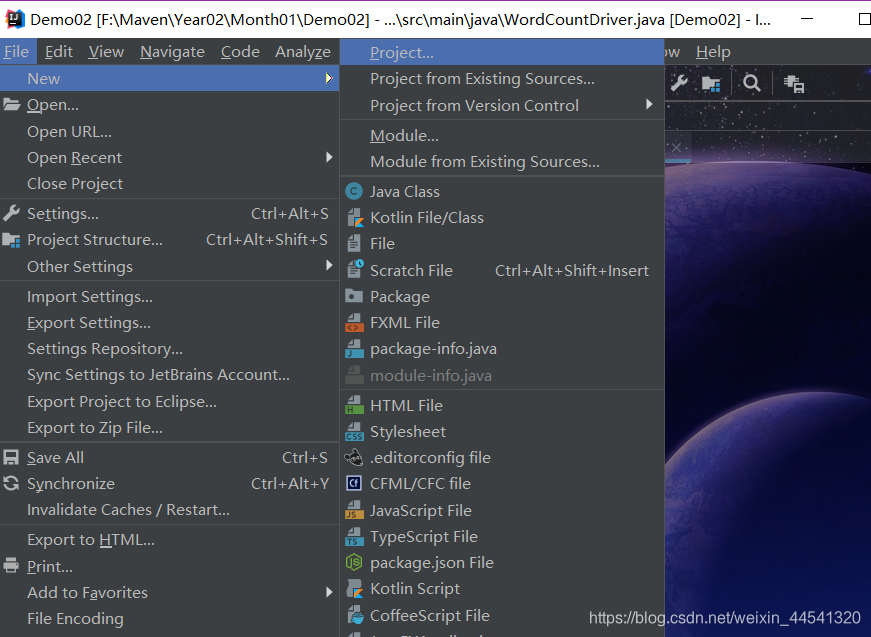

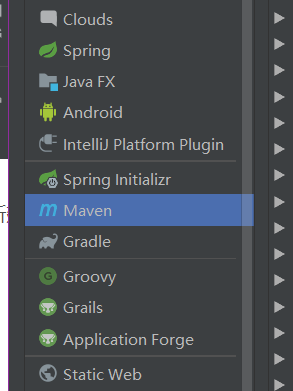

第三步: 打开编码器(我用的是idea)

新建一个项目…

创建maven项目 不用选择框架

修改pom文件

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd"><modelVersion>4.0.0</modelVersion><groupId>cn.itcast</groupId><artifactId>mapreduce</artifactId><version>1.0-SNAPSHOT</version><repositories><repository><id>cloudera</id><url>https://repository.cloudera.com/artifactory/cloudera-repos/</url></repository></repositories><dependencies><dependency><groupId>org.apache.Hadoop</groupId><artifactId>Hadoop-client</artifactId><version>2.6.0-mr1-cdh5.14.0</version></dependency><dependency><groupId>org.apache.Hadoop</groupId><artifactId>Hadoop-common</artifactId><version>2.6.0-cdh5.14.0</version></dependency><dependency><groupId>org.apache.Hadoop</groupId><artifactId>Hadoop-hdfs</artifactId><version>2.6.0-cdh5.14.0</version></dependency><dependency><groupId>org.apache.Hadoop</groupId><artifactId>Hadoop-mapreduce-client-core</artifactId><version>2.6.0-cdh5.14.0</version></dependency><dependency><groupId>junit</groupId><artifactId>junit</artifactId><version>4.11</version><scope>test</scope></dependency><dependency><groupId>org.testng</groupId><artifactId>testng</artifactId><version>RELEASE</version></dependency></dependencies><build><plugins><plugin><groupId>org.apache.maven.plugins</groupId><artifactId>maven-compiler-plugin</artifactId><version>3.0</version><configuration><source>1.8</source><target>1.8</target><encoding>UTF-8</encoding></configuration></plugin><plugin><groupId>org.apache.maven.plugins</groupId><artifactId>maven-shade-plugin</artifactId><version>2.4.3</version><executions><execution><phase>package</phase><goals><goal>shade</goal></goals><configuration><minimizeJar>true</minimizeJar></configuration></execution></executions></plugin></plugins></build>

</project>

定义一个mapper类

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper;import java.io.IOException;/*** @Author:Lenvo* @Description:* @Date: 2019-11-12 10:32*/

public class WordCountMap extends Mapper<LongWritable, Text, Text, LongWritable> {@Overrideprotected void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {//key 指的是游戏中的编号//key代码里是 这行数据的偏移量//value 一串图形// value zhangsan,lisi,wangwu//1 将value 从text转为StringString datas = value.toString();//2 切分数据 zhangsan lisi wangwuString[] splits = datas.split(",");//3 遍历输出/* for (int i = 0; i < splits.length; i++) {}*/for (String data : splits) {//输出数据context.write(new Text(data), new LongWritable(1));}//zhangsan 1 输出一次(送一次)//lisi 1 输出一次(送一次)//wangwu 1 输出一次(送一次)}}

定义一个reducer类

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Reducer;import java.io.IOException;/*** @Author:Lenvo* @Description:* @Date: 2019-11-12 11:39*/

public class WordCountReduce extends Reducer<Text, LongWritable, Text, LongWritable> {//zhangsan 1,1,1,1//lisi 1,1,1@Overrideprotected void reduce(Text key, Iterable<LongWritable> values, Context context) throws IOException, InterruptedException {//key 是游戏中的图形(zhangsan lisi )//values 好多 1long sum = 0;//遍历valuesfor (LongWritable value : values) {sum += value.get();}//输出context.write(key, new LongWritable(sum));}

}定义一个主类,用来描述job并提交job

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.conf.Configured;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.TextInputFormat;

import org.apache.hadoop.mapreduce.lib.output.TextOutputFormat;

import org.apache.hadoop.util.Tool;

import org.apache.hadoop.util.ToolRunner;/*** @Author:Lenvo* @Description:* @Date: 2019-11-12 11:39*/

public class WordCountDriver extends Configured implements Tool {@Overridepublic int run(String[] args) throws Exception {//将已经编写好的Map Reduce添加到计算框架中//1 、实例一个jobJob job = Job.getInstance(new Configuration(),"WordCount34");//2、使用job 设置读取数据(包括数据的路径)job.setInputFormatClass(TextInputFormat.class);TextInputFormat.addInputPath(job,new Path("F:\\aaa.txt"));//3、使用job 设置MAP类(map 输出的类型)job.setMapperClass(WordCountMap.class);job.setMapOutputKeyClass(Text.class);job.setMapOutputValueClass(LongWritable.class);//4、使用job 设置Reduce类(Reduce 输入和输出的类型)job.setReducerClass(WordCountReduce.class);job.setOutputKeyClass(Text.class);job.setOutputValueClass(LongWritable.class);//5、使用job 设置数据的输出路径job.setOutputFormatClass(TextOutputFormat.class);TextOutputFormat.setOutputPath(job,new Path("F:\\BBB.txt"));//6、返回执行状态编号return job.waitForCompletion(true)?0:1;}//执行jobpublic static void main(String[] args) throws Exception {int run = ToolRunner.run(new WordCountDriver(), args);System.out.println(run);}}点击执行 出现以下结果 执行成功

F:\ruanjian\Java\bin\java.exe "-javaagent:F:\ruanjian\IntelliJ IDEA 2018.3.5\lib\idea_rt.jar=52321:F:\ruanjian\IntelliJ IDEA 2018.3.5\bin" -Dfile.encoding=UTF-8 -classpath F:\ruanjian\Java\jre\lib\charsets.jar;F:\ruanjian\Java\jre\lib\deploy.jar;F:\ruanjian\Java\jre\lib\ext\access-bridge-64.jar;F:\ruanjian\Java\jre\lib\ext\cldrdata.jar;F:\ruanjian\Java\jre\lib\ext\dnsns.jar;F:\ruanjian\Java\jre\lib\ext\jaccess.jar;F:\ruanjian\Java\jre\lib\ext\jfxrt.jar;F:\ruanjian\Java\jre\lib\ext\localedata.jar;F:\ruanjian\Java\jre\lib\ext\nashorn.jar;F:\ruanjian\Java\jre\lib\ext\sunec.jar;F:\ruanjian\Java\jre\lib\ext\sunjce_provider.jar;F:\ruanjian\Java\jre\lib\ext\sunmscapi.jar;F:\ruanjian\Java\jre\lib\ext\sunpkcs11.jar;F:\ruanjian\Java\jre\lib\ext\zipfs.jar;F:\ruanjian\Java\jre\lib\javaws.jar;F:\ruanjian\Java\jre\lib\jce.jar;F:\ruanjian\Java\jre\lib\jfr.jar;F:\ruanjian\Java\jre\lib\jfxswt.jar;F:\ruanjian\Java\jre\lib\jsse.jar;F:\ruanjian\Java\jre\lib\management-agent.jar;F:\ruanjian\Java\jre\lib\plugin.jar;F:\ruanjian\Java\jre\lib\resources.jar;F:\ruanjian\Java\jre\lib\rt.jar;F:\Maven\Year02\Month01\Demo02\target\classes;F:\ruanjian\apache-maven-3.3.9\repository\org\apache\hadoop\hadoop-client\2.6.0-mr1-cdh5.14.0\Hadoop-client-2.6.0-mr1-cdh5.14.0.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\apache\hadoop\hadoop-common\2.6.0-cdh5.14.0\hadoop-common-2.6.0-cdh5.14.0.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\apache\hadoop\hadoop-hdfs\2.6.0-cdh5.14.0\hadoop-hdfs-2.6.0-cdh5.14.0.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\apache\hadoop\hadoop-core\2.6.0-mr1-cdh5.14.0\hadoop-core-2.6.0-mr1-cdh5.14.0.jar;F:\ruanjian\apache-maven-3.3.9\repository\hsqldb\hsqldb\1.8.0.10\hsqldb-1.8.0.10.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\apache\hadoop\hadoop-annotations\2.6.0-cdh5.14.0\hadoop-annotations-2.6.0-cdh5.14.0.jar;F:\ruanjian\apache-maven-3.3.9\repository\com\google\guava\guava\11.0.2\guava-11.0.2.jar;F:\ruanjian\apache-maven-3.3.9\repository\commons-cli\commons-cli\1.2\commons-cli-1.2.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\apache\commons\commons-math3\3.1.1\commons-math3-3.1.1.jar;F:\ruanjian\apache-maven-3.3.9\repository\xmlenc\xmlenc\0.52\xmlenc-0.52.jar;F:\ruanjian\apache-maven-3.3.9\repository\commons-httpclient\commons-httpclient\3.1\commons-httpclient-3.1.jar;F:\ruanjian\apache-maven-3.3.9\repository\commons-codec\commons-codec\1.4\commons-codec-1.4.jar;F:\ruanjian\apache-maven-3.3.9\repository\commons-io\commons-io\2.4\commons-io-2.4.jar;F:\ruanjian\apache-maven-3.3.9\repository\commons-net\commons-net\3.1\commons-net-3.1.jar;F:\ruanjian\apache-maven-3.3.9\repository\commons-collections\commons-collections\3.2.2\commons-collections-3.2.2.jar;F:\ruanjian\apache-maven-3.3.9\repository\javax\servlet\servlet-api\2.5\servlet-api-2.5.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\mortbay\jetty\jetty\6.1.26.cloudera.4\jetty-6.1.26.cloudera.4.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\mortbay\jetty\jetty-util\6.1.26.cloudera.4\jetty-util-6.1.26.cloudera.4.jar;F:\ruanjian\apache-maven-3.3.9\repository\com\sun\jersey\jersey-core\1.9\jersey-core-1.9.jar;F:\ruanjian\apache-maven-3.3.9\repository\com\sun\jersey\jersey-json\1.9\jersey-json-1.9.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\codehaus\jettison\jettison\1.1\jettison-1.1.jar;F:\ruanjian\apache-maven-3.3.9\repository\com\sun\xml\bind\jaxb-impl\2.2.3-1\jaxb-impl-2.2.3-1.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\codehaus\jackson\jackson-jaxrs\1.8.3\jackson-jaxrs-1.8.3.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\codehaus\jackson\jackson-xc\1.8.3\jackson-xc-1.8.3.jar;F:\ruanjian\apache-maven-3.3.9\repository\com\sun\jersey\jersey-server\1.9\jersey-server-1.9.jar;F:\ruanjian\apache-maven-3.3.9\repository\asm\asm\3.1\asm-3.1.jar;F:\ruanjian\apache-maven-3.3.9\repository\tomcat\jasper-compiler\5.5.23\jasper-compiler-5.5.23.jar;F:\ruanjian\apache-maven-3.3.9\repository\tomcat\jasper-runtime\5.5.23\jasper-runtime-5.5.23.jar;F:\ruanjian\apache-maven-3.3.9\repository\javax\servlet\jsp\jsp-api\2.1\jsp-api-2.1.jar;F:\ruanjian\apache-maven-3.3.9\repository\commons-el\commons-el\1.0\commons-el-1.0.jar;F:\ruanjian\apache-maven-3.3.9\repository\commons-logging\commons-logging\1.1.3\commons-logging-1.1.3.jar;F:\ruanjian\apache-maven-3.3.9\repository\log4j\log4j\1.2.17\log4j-1.2.17.jar;F:\ruanjian\apache-maven-3.3.9\repository\net\java\dev\jets3t\jets3t\0.9.0\jets3t-0.9.0.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\apache\httpcomponents\httpclient\4.1.2\httpclient-4.1.2.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\apache\httpcomponents\httpcore\4.1.2\httpcore-4.1.2.jar;F:\ruanjian\apache-maven-3.3.9\repository\com\jamesmurty\utils\java-xmlbuilder\0.4\java-xmlbuilder-0.4.jar;F:\ruanjian\apache-maven-3.3.9\repository\commons-lang\commons-lang\2.6\commons-lang-2.6.jar;F:\ruanjian\apache-maven-3.3.9\repository\commons-configuration\commons-configuration\1.6\commons-configuration-1.6.jar;F:\ruanjian\apache-maven-3.3.9\repository\commons-digester\commons-digester\1.8\commons-digester-1.8.jar;F:\ruanjian\apache-maven-3.3.9\repository\commons-beanutils\commons-beanutils\1.7.0\commons-beanutils-1.7.0.jar;F:\ruanjian\apache-maven-3.3.9\repository\commons-beanutils\commons-beanutils-core\1.8.0\commons-beanutils-core-1.8.0.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\slf4j\slf4j-api\1.7.5\slf4j-api-1.7.5.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\slf4j\slf4j-log4j12\1.7.5\slf4j-log4j12-1.7.5.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\codehaus\jackson\jackson-core-asl\1.8.8\jackson-core-asl-1.8.8.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\codehaus\jackson\jackson-mapper-asl\1.8.8\jackson-mapper-asl-1.8.8.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\apache\avro\avro\1.7.6-cdh5.14.0\avro-1.7.6-cdh5.14.0.jar;F:\ruanjian\apache-maven-3.3.9\repository\com\thoughtworks\paranamer\paranamer\2.3\paranamer-2.3.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\xerial\snappy\snappy-java\1.0.4.1\snappy-java-1.0.4.1.jar;F:\ruanjian\apache-maven-3.3.9\repository\com\google\protobuf\protobuf-java\2.5.0\protobuf-java-2.5.0.jar;F:\ruanjian\apache-maven-3.3.9\repository\com\google\code\gson\gson\2.2.4\gson-2.2.4.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\apache\hadoop\hadoop-auth\2.6.0-cdh5.14.0\hadoop-auth-2.6.0-cdh5.14.0.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\apache\directory\server\apacheds-kerberos-codec\2.0.0-M15\apacheds-kerberos-codec-2.0.0-M15.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\apache\directory\server\apacheds-i18n\2.0.0-M15\apacheds-i18n-2.0.0-M15.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\apache\directory\api\api-asn1-api\1.0.0-M20\api-asn1-api-1.0.0-M20.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\apache\directory\api\api-util\1.0.0-M20\api-util-1.0.0-M20.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\apache\curator\curator-framework\2.7.1\curator-framework-2.7.1.jar;F:\ruanjian\apache-maven-3.3.9\repository\com\jcraft\jsch\0.1.42\jsch-0.1.42.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\apache\curator\curator-client\2.7.1\curator-client-2.7.1.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\apache\curator\curator-recipes\2.7.1\curator-recipes-2.7.1.jar;F:\ruanjian\apache-maven-3.3.9\repository\com\google\code\findbugs\jsr305\3.0.0\jsr305-3.0.0.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\apache\htrace\htrace-core4\4.0.1-incubating\htrace-core4-4.0.1-incubating.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\apache\zookeeper\zookeeper\3.4.5-cdh5.14.0\zookeeper-3.4.5-cdh5.14.0.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\apache\commons\commons-compress\1.4.1\commons-compress-1.4.1.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\tukaani\xz\1.0\xz-1.0.jar;F:\ruanjian\apache-maven-3.3.9\repository\commons-daemon\commons-daemon\1.0.13\commons-daemon-1.0.13.jar;F:\ruanjian\apache-maven-3.3.9\repository\io\netty\netty\3.10.5.Final\netty-3.10.5.Final.jar;F:\ruanjian\apache-maven-3.3.9\repository\io\netty\netty-all\4.0.23.Final\netty-all-4.0.23.Final.jar;F:\ruanjian\apache-maven-3.3.9\repository\xerces\xercesImpl\2.9.1\xercesImpl-2.9.1.jar;F:\ruanjian\apache-maven-3.3.9\repository\xml-apis\xml-apis\1.3.04\xml-apis-1.3.04.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\fusesource\leveldbjni\leveldbjni-all\1.8\leveldbjni-all-1.8.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\apache\hadoop\hadoop-mapreduce-client-core\2.6.0-cdh5.14.0\Hadoop-mapreduce-client-core-2.6.0-cdh5.14.0.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\apache\hadoop\hadoop-yarn-common\2.6.0-cdh5.14.0\hadoop-yarn-common-2.6.0-cdh5.14.0.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\apache\hadoop\hadoop-yarn-api\2.6.0-cdh5.14.0\hadoop-yarn-api-2.6.0-cdh5.14.0.jar;F:\ruanjian\apache-maven-3.3.9\repository\javax\xml\bind\jaxb-api\2.2.2\jaxb-api-2.2.2.jar;F:\ruanjian\apache-maven-3.3.9\repository\javax\xml\stream\stax-api\1.0-2\stax-api-1.0-2.jar;F:\ruanjian\apache-maven-3.3.9\repository\javax\activation\activation\1.1\activation-1.1.jar;F:\ruanjian\apache-maven-3.3.9\repository\com\sun\jersey\jersey-client\1.9\jersey-client-1.9.jar;F:\ruanjian\apache-maven-3.3.9\repository\com\google\inject\guice\3.0\guice-3.0.jar;F:\ruanjian\apache-maven-3.3.9\repository\javax\inject\javax.inject\1\javax.inject-1.jar;F:\ruanjian\apache-maven-3.3.9\repository\aopalliance\aopalliance\1.0\aopalliance-1.0.jar;F:\ruanjian\apache-maven-3.3.9\repository\com\sun\jersey\contribs\jersey-guice\1.9\jersey-guice-1.9.jar;F:\ruanjian\apache-maven-3.3.9\repository\com\google\inject\extensions\guice-servlet\3.0\guice-servlet-3.0.jar;F:\ruanjian\apache-maven-3.3.9\repository\org\testng\testng\7.0.0\testng-7.0.0.jar;F:\ruanjian\apache-maven-3.3.9\repository\com\beust\jcommander\1.72\jcommander-1.72.jar WordCountDriver

19/11/12 16:08:17 INFO Configuration.deprecation: session.id is deprecated. Instead, use dfs.metrics.session-id

19/11/12 16:08:17 INFO jvm.JvmMetrics: Initializing JVM Metrics with processName=JobTracker, sessionId=

19/11/12 16:08:17 WARN mapred.JobClient: Use GenericOptionsParser for parsing the arguments. Applications should implement Tool for the same.

19/11/12 16:08:17 WARN mapred.JobClient: No job jar file set. User classes may not be found. See JobConf(Class) or JobConf#setJar(String).

19/11/12 16:08:17 INFO input.FileInputFormat: Total input paths to process : 1

19/11/12 16:08:17 INFO mapred.LocalJobRunner: OutputCommitter set in config null

19/11/12 16:08:17 INFO mapred.JobClient: Running job: job_local868986662_0001

19/11/12 16:08:17 INFO mapred.LocalJobRunner: OutputCommitter is org.apache.hadoop.mapreduce.lib.output.FileOutputCommitter

19/11/12 16:08:17 INFO mapred.LocalJobRunner: Waiting for map tasks

19/11/12 16:08:17 INFO mapred.LocalJobRunner: Starting task: attempt_local868986662_0001_m_000000_0

19/11/12 16:08:18 WARN mapreduce.Counters: Group org.apache.hadoop.mapred.Task$Counter is deprecated. Use org.apache.hadoop.mapreduce.TaskCounter instead

19/11/12 16:08:18 INFO mapred.Task: Using ResourceCalculatorPlugin : null

19/11/12 16:08:18 INFO mapred.MapTask: Processing split: file:/F:/aaa.txt:0+73

19/11/12 16:08:18 INFO mapred.MapTask: Map output collector class = org.apache.hadoop.mapred.MapTask$MapOutputBuffer

19/11/12 16:08:18 INFO mapred.MapTask: io.sort.mb = 100

19/11/12 16:08:18 INFO mapred.MapTask: data buffer = 79691776/99614720

19/11/12 16:08:18 INFO mapred.MapTask: record buffer = 262144/327680

19/11/12 16:08:18 INFO mapred.LocalJobRunner:

19/11/12 16:08:18 INFO mapred.MapTask: Starting flush of map output

19/11/12 16:08:18 INFO mapred.MapTask: Finished spill 0

19/11/12 16:08:18 INFO mapred.Task: Task:attempt_local868986662_0001_m_000000_0 is done. And is in the process of commiting

19/11/12 16:08:18 INFO mapred.LocalJobRunner:

19/11/12 16:08:18 INFO mapred.Task: Task 'attempt_local868986662_0001_m_000000_0' done.

19/11/12 16:08:18 INFO mapred.LocalJobRunner: Finishing task: attempt_local868986662_0001_m_000000_0

19/11/12 16:08:18 INFO mapred.LocalJobRunner: Map task executor complete.

19/11/12 16:08:18 WARN mapreduce.Counters: Group org.apache.hadoop.mapred.Task$Counter is deprecated. Use org.apache.hadoop.mapreduce.TaskCounter instead

19/11/12 16:08:18 INFO mapred.Task: Using ResourceCalculatorPlugin : null

19/11/12 16:08:18 INFO mapred.LocalJobRunner:

19/11/12 16:08:18 INFO mapred.Merger: Merging 1 sorted segments

19/11/12 16:08:18 INFO mapred.Merger: Down to the last merge-pass, with 1 segments left of total size: 193 bytes

19/11/12 16:08:18 INFO mapred.LocalJobRunner:

19/11/12 16:08:18 INFO mapred.Task: Task:attempt_local868986662_0001_r_000000_0 is done. And is in the process of commiting

19/11/12 16:08:18 INFO mapred.LocalJobRunner:

19/11/12 16:08:18 INFO mapred.Task: Task attempt_local868986662_0001_r_000000_0 is allowed to commit now

19/11/12 16:08:18 INFO output.FileOutputCommitter: Saved output of task 'attempt_local868986662_0001_r_000000_0' to F:/BBB.txt

19/11/12 16:08:18 INFO mapred.LocalJobRunner: reduce > reduce

19/11/12 16:08:18 INFO mapred.Task: Task 'attempt_local868986662_0001_r_000000_0' done.

19/11/12 16:08:18 INFO mapred.JobClient: map 100% reduce 100%

19/11/12 16:08:18 INFO mapred.JobClient: Job complete: job_local868986662_0001

19/11/12 16:08:18 INFO mapred.JobClient: Counters: 17

19/11/12 16:08:18 INFO mapred.JobClient: File System Counters

19/11/12 16:08:18 INFO mapred.JobClient: FILE: Number of bytes read=613

19/11/12 16:08:18 INFO mapred.JobClient: FILE: Number of bytes written=339766

19/11/12 16:08:18 INFO mapred.JobClient: FILE: Number of read operations=0

19/11/12 16:08:18 INFO mapred.JobClient: FILE: Number of large read operations=0

19/11/12 16:08:18 INFO mapred.JobClient: FILE: Number of write operations=0

19/11/12 16:08:18 INFO mapred.JobClient: Map-Reduce Framework

19/11/12 16:08:18 INFO mapred.JobClient: Map input records=4

19/11/12 16:08:18 INFO mapred.JobClient: Map output records=12

19/11/12 16:08:18 INFO mapred.JobClient: Map output bytes=167

19/11/12 16:08:18 INFO mapred.JobClient: Input split bytes=81

19/11/12 16:08:18 INFO mapred.JobClient: Combine input records=0

19/11/12 16:08:18 INFO mapred.JobClient: Combine output records=0

19/11/12 16:08:18 INFO mapred.JobClient: Reduce input groups=9

19/11/12 16:08:18 INFO mapred.JobClient: Reduce shuffle bytes=0

19/11/12 16:08:18 INFO mapred.JobClient: Reduce input records=12

19/11/12 16:08:18 INFO mapred.JobClient: Reduce output records=9

19/11/12 16:08:18 INFO mapred.JobClient: Spilled Records=24

19/11/12 16:08:18 INFO mapred.JobClient: Total committed heap usage (bytes)=514850816

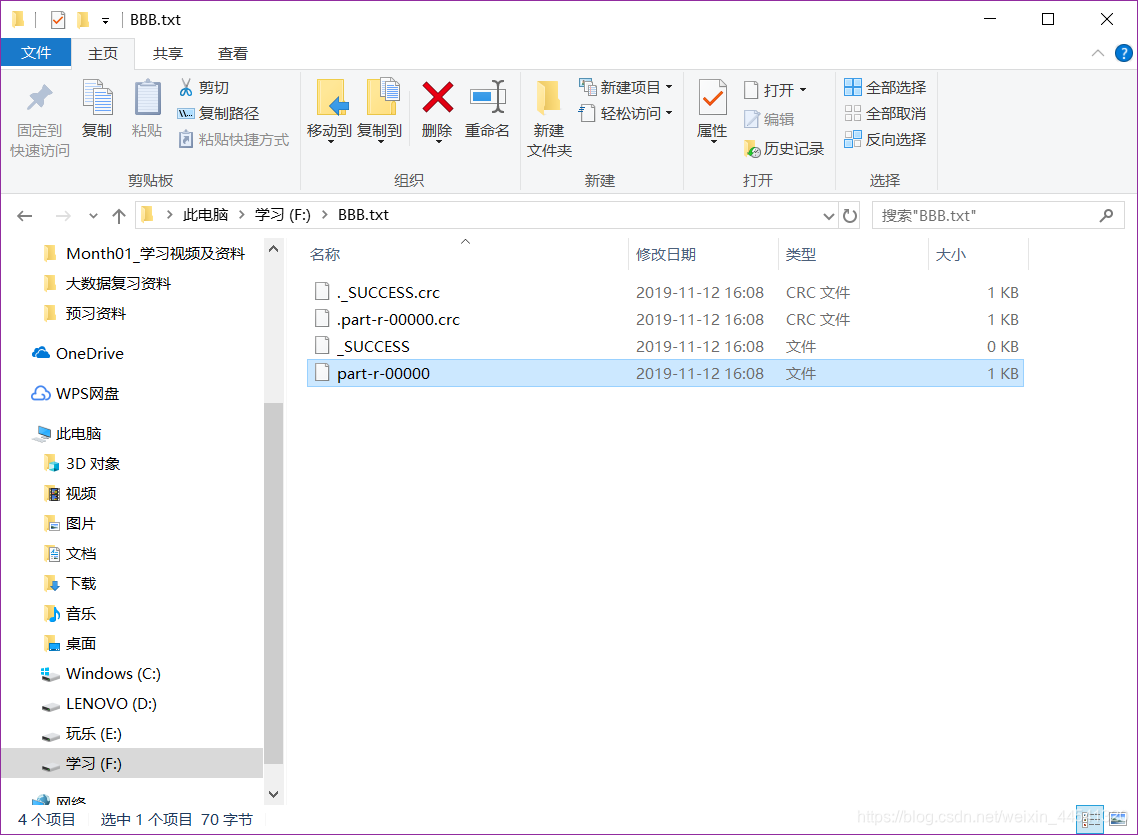

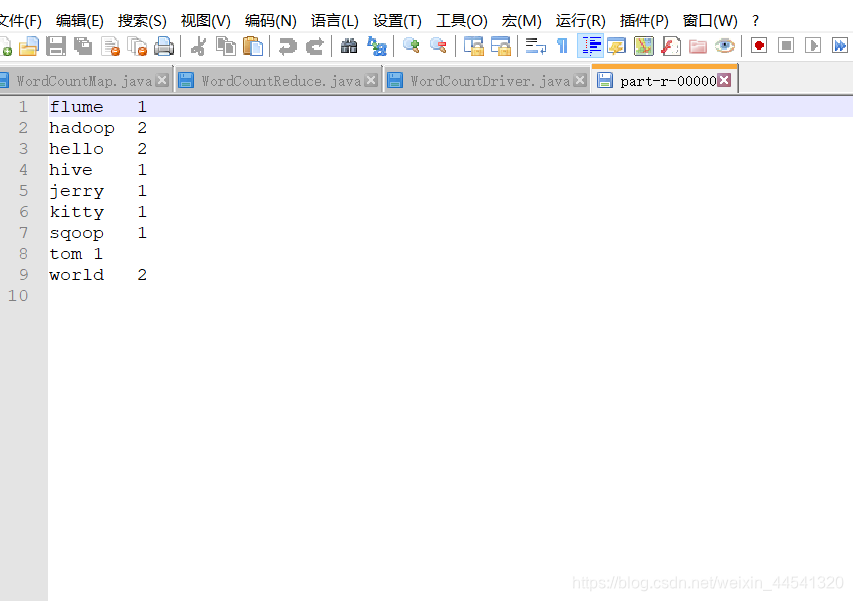

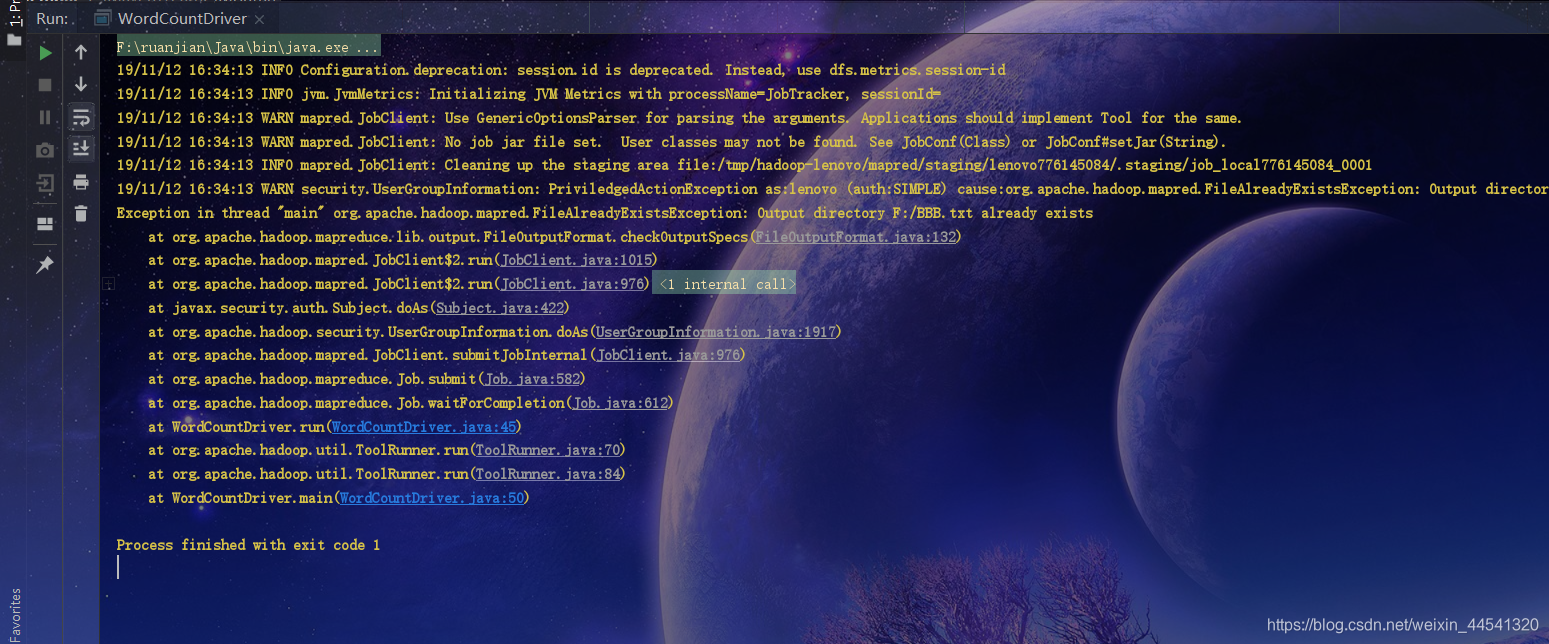

0Process finished with exit code 0最后在保存路径中查看

用代码编辑器中打开查看 可看到以下结果

MapReduce初体验结束

注意出现这个错误时 说明保存路径中已有计算结果的文件 不可再次保存(因为不支持覆盖)

相关文章:

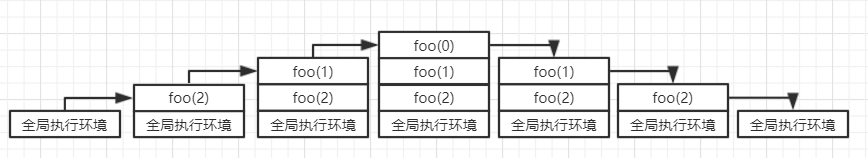

傻傻分不清的javascript运行机制

学习到javascript的运行机制时,有几个概念经常出现在各种文章中且容易混淆。Execution Context(执行环境或执行上下文),Context Stack (执行栈),Variable Object(VO: 变量对象),Active Object(AO: 活动对象),LexicalEn…

SVN linux 服务器端配置

一. SVN 简单介绍Subversion(SVN) 是一个开源的版本号控制系統, 也就是说 Subversion 管理着随时间改变的数据。 这些数据放置在一个中央资料档案库 (repository) 中。 这个档案库非常像一个普通的文件server, 只是它会记住每一次文件的变动。 这样你就能够把档案恢复到旧的版本…

用C++开发Web应用

表现: XHTML/CSS/Javascript 库:Extjs 逻辑/服务器端:C CGI/Fastcgi 库:Wt Boost 数据库:MySQL/XML Web应用计划项目: Web DesktopSoft RobotWeb Instant MessageWeb Office SuitWeb IDE(compiler,…

C#2.0实例程序STEP BY STEP--实例二:数据类型

C#2.0实例程序STEP BY STEP--实例二:数据类型 与其他.NET语言一样,C#支持Common Type Sysem(CTS),其中的数据类型集合不仅包含我们熟悉的基本类型,例如int,char和float等,还包括比较复杂的类型,例如内部的string类型和表示货币值的decimal类型。而且&am…

注解--python库--matplotlib

import matplotlib.pyplot as plt import numpy as npx np.linspace(-3, 3, 50) y 2*x 1plt.figure(num1, figsize(8, 5),) plt.plot(x, y,)ax plt.gca() ax.spines[right].set_color(none)#右边框为空 ax.spines[top].set_color(none)#上边框为空 ax.xaxis.set_ticks_posi…

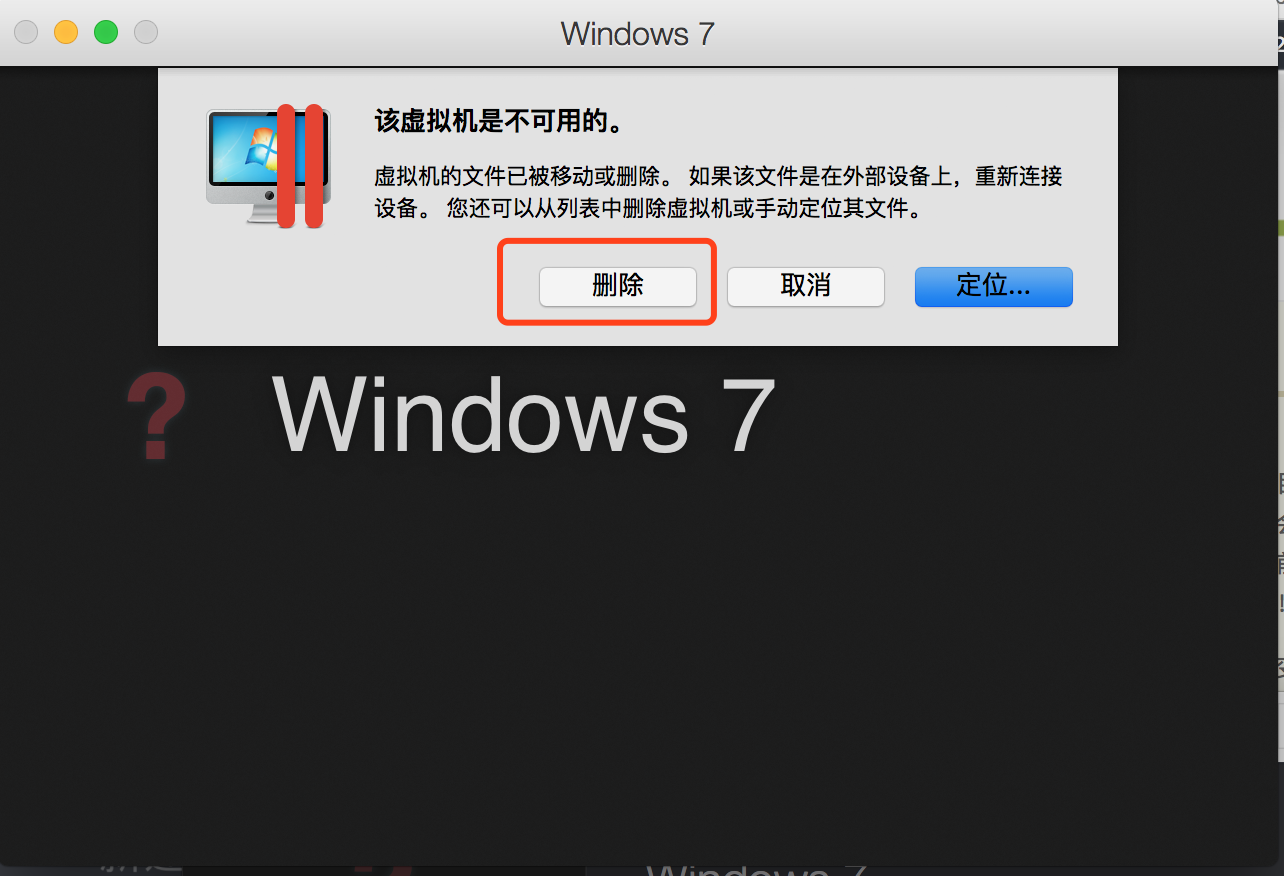

Parallels Desktop 重装系统

安装教程,大家可以在网上找找 现在我想重装系统,怎么弄呢? 1、~/Documents/Parallels 目录下那个PVM后缀的文件直接删除 2、重装找开虚拟机,会弹出一个框,说找不到系统,点击删除。 3、之后重新安装即可。 转…

用tcpdump查看端口包

例如tcpdump -X -s1600 -i eth1 dst port 20072 -wdump.dat 特别注意-s的使用,不使用该参数,则只会接收默认大小的一个数据包,我机器上是42b 得到的数据包可以通过Ethereal软件查看详细包结构和内容。 很好用! 转载于:https://ww…

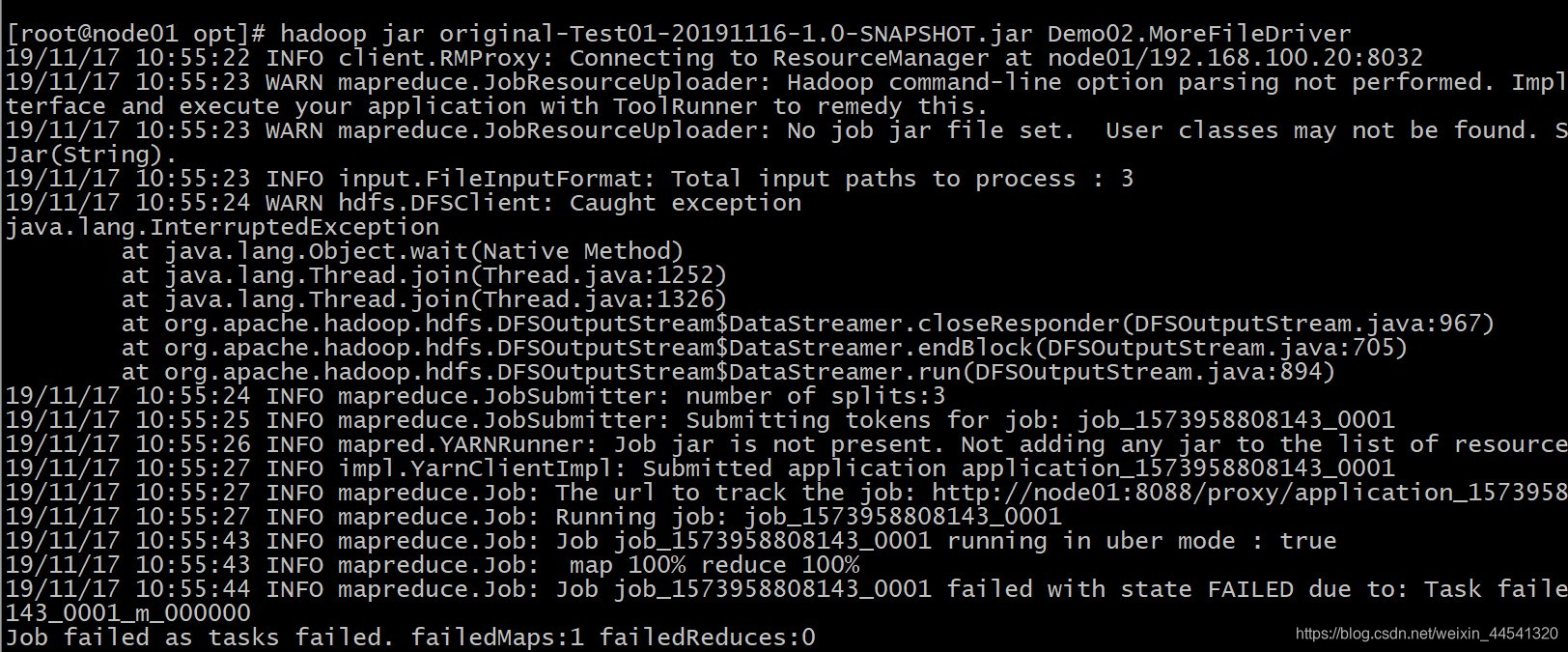

Caught exception java.lang.interruptedException(在集群上进行多个文件合并压缩时出错)

问题:将mapreduce程序打成JAR包提交给yarn集群,用hadoop命令启动后发现报以下错误: 原因:经检查后发现少了这一行代码,此代码的作用是通过传入的class,找到job的JAR包。 解决方法:添上此行代码,…

是北京晚报!不,是中国最大的讽刺!!!

转载请注明出处:[url]http://technet.blog.51cto.com/[/url],这还是很久以前写的呢,今天无意翻出来了,发上来与大家共享.是北京晚报!不,是中国最大的讽刺!!! 昨天在北大青鸟上完课,坐车回家,因要2个小时的车程,怕闲来无聊&…

nomn文件分析

#encodinggbk import os import re import math from os import path 手动输入文件nmon文件路径,要截取的开始时间,结束时间 rootdirE:\\pylianxi\\ceshi #input("请输入文件路径:") start_time"14:46" #截取的…

Vmware Workstation VMX 在资源管理器中杀不掉(虚拟机繁忙导致无法关机)

使用vmware的时候出现 虚拟机繁忙 的情况导致无法关机,然后使用任务管理器结束vmware进程,之后却发现在资源监视器中有一个VMware Workstation VMX进程始终关不掉,获得管理员权限去杀或者重启都没有用。 解决办法:打开win10的应用…

BGA封装芯片手工焊接攻略

转载于:http://blog.sina.com.cn/s/blog_70bb32080100lx1y.html 我毕设的很多板上都有BGA芯片,刚开始我觉得这东西实在是没有办法焊接。幸运的是我们研究所的另外一个研究室花了30多万买了个BGA焊接设备,我去蹭了2次,可惜要看人家…

40个常用的网站制作技巧

1. οncοntextmenu "window.event.returnValuefalse " 将彻底屏蔽鼠标右键 <table border οncοntextmenureturn(false)> <td> no </table> 可用于Table 2. <body onselectstart "return false "> 取消选取…

[Flash开发笔记] 如何在as2.0中使用自定义类事件

as2编程中,我们通常要处理一些异步加载的数据,有点类似ajax中的callback,即我们不知道何时数据才会返回,并且只有当数据返回时,执行我们定义的操作。在flash6及以前,我们会常常碰到从外部加载一张图片或一段…

.NET开发不可不知、不可不用的辅助类(三)(报表导出---终结版)

.NET导出报表一般是采用导出Excel报表的方式输出内容。而这又分为两种方式:使用Excel模板方式和使用网页输出Excel格式两种。首先介绍简单的一种,网页输出Excel内容,这种不需要引用Excel的程序集。/**//// <summary> /// 报表导出辅…

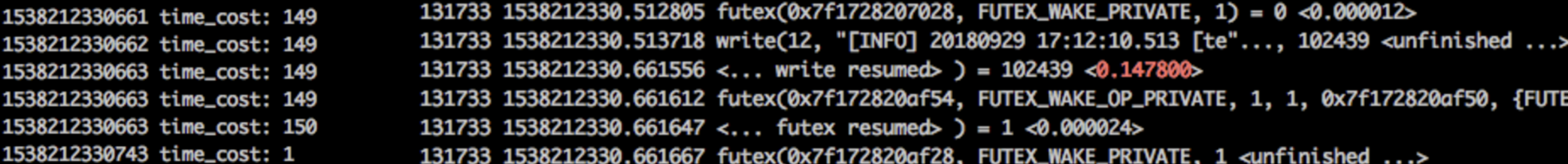

从应用到内核查接口超时(中)

应用复现 接着上文 从应用到内核查接口超时(上) 继续排查导致接口超时的原因。 转载随意,文章会持续修订,请注明来源地址:https://zhenbianshu.github.io 。 Jdk 的 native 方法当然不是终点,虽然发现 Jdk、…

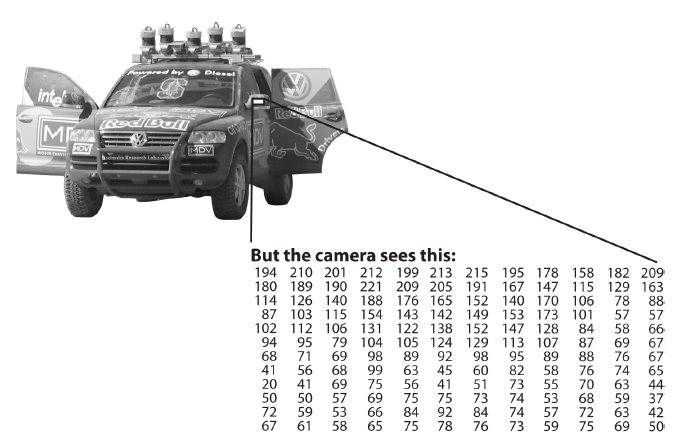

OpenCV 之 Mat 类

数字图像可看作一个数值矩阵, 其中的每个元素代表一个像素点,如下图所示: OpenCV 中,用 Mat 来表示该数值矩阵,它是很关键的一种数据结构,因为 OpenCV 中的大部分函数都和 Mat 有关: 有的是 Mat 的成员函数…

hbase shell编码显示中文

最近测试hbase shell,碰到个中文显示编码问题,最后通过Python解决了问题,具体操作如下: hbase(main):015:0* scan ‘fr_test_hbase:test_log1’ ROW COLUMNCELL 10001 columninfo:name, timestamp1500448006065, valuetmr\xE4\xB…

AJAX范例大搜罗(转载)

1.每天一个AJAX 该网站提供了很多非常酷的AJAX例子,号称是每天更新一个。 网址:http://www.ajaxcompilation.com/ 2.210个AJAX框架 一个不错的提供Ajax范例的网站,Ajax框架已更新至210个。 网址:http:…

Hbase的过滤器查询

hbase过滤器的比较运算符: LESS < LESS_OR_EQUAL < EQUAL NOT_EQUAL <> GREATER_OR_EQUAL > GREATER > NO_OP 排除所有 hbase过滤器的比较运算符: BinaryComparator 按字节索引顺序比较指定字节数组,采用Bytes.compareTo(…

python的进程

多进程概念: 由于GIL的存在,python中的多线程其实并不是真正的多线程,如果想要充分地使用多核CPU的资源,在python中大部分情况需要使用多进程。python提供了非常好用的多线程包(multiprocessing),只需要定义一个函…

071204 晴

晚上打算把周末的剩余任务做完去池袋kitty店预习作文把电脑慢的原因查出来电脑传照片的方法一部电影一本书一本杂志单词 转载于:https://www.cnblogs.com/loverain/archive/2007/12/04/982210.html

区块链深度好文

http://www.huhangfei.com/post/4/转载于:https://www.cnblogs.com/vinplezhang/p/7325161.html

工作流引擎设计之退回任务定义

退回(Rollback Work Item)退回是针对本人(工作流参与者)的“待办任务”的操作,即参与者主动退回待办任务列表中的任务。为什么要退回?参与者接受任务后,发现不应由自己办理此任务或上一步的执行…

HBase常用API操作

文章目录第一步:创建maven工程,导入jar包第二步:开发javaAPI操作HBase表数据1、创建表myuser2、向表中添加数据3、查询数据3.1、 按照rowkey进行查询获取所有列的所有值3.2、 按照rowkey查询指定列族下面的指定列的值3.3、 通过startRowKey和…

Kanade's trio 2017多校#3 trie

求数组中i<j<k 并且ai^aj<aj^ak的三元组组数 枚举插入ak,让ak中每一位作为最高位,查找字典树内最高位不同的数字数量 注意把ak的每个前缀做一个bad标记 存储让这个前缀作为i可以与字典树内形成i,j对的个数,这些不满足i<j ai : 1…

使用VS2005进行代码覆盖率分析

下面通过一个简单的例子来讲解VS2005是如何做代码分析的(此处所做的代码分析是在单元测试之后进行的,其分析代码仍然使用上节的做和代码) 1、上节的原始代码和单元测试代码分别如下: //原始代码 using System; using System.Colle…

云计算时代的数据库运行

云计算时代的高可用数据库是可扩展、容错且与任何私有云或公共云兼容的数据库实例。它们旨在提供业务连续性,而不会因任何类型的硬件或网络故障而导致用户体验的影响。其核心设计原则是消除任何单点故障,并提供平稳的故障转移体验。 公共云和私有云使企业…

Java:在Bean中使用PropertyChangeSupport支持PropertyChangeListeners

本文主要介绍如何使用PropertyChangeSupport类来支持关联属性事件的触发。author: ZJ 2007-8-3Blog: [url]http://zhangjunhd.blog.51cto.com/[/url]JavaBean的属性与一般Java程序中所指的属性,或者说与所有面向对象的程序设计语言中对象的属性是一个概念࿰…

【做题】SRM701 Div1 Hard - FibonacciStringSum——数学和式&矩阵快速幂

原文链接 https://www.cnblogs.com/cly-none/p/SRM701Div1C.html 题意:定义"Fibonacci string"为没有连续1的01串。现在,给出\(a,b\),定义一个"Fibonacci string"的权值为\(x^a y^b\),其中\(x\)为0的个数&…