XPath与多线程爬虫

一. Xpath的介绍与配置

1. XPath是什么

XPath是一门语言

XPath可以在XML文档中查找信息

XPath支持HTML

XPath通过元素和属性进行导航

总结:

XPath可以用来提取信息(和正则表达式类似)

XPath比正则表达式更加厉害

XPath比正则表达式更加的简单

如果你之前用正则表达式进行开发,很多时候,明明感觉自己的匹配是正确的,但是就是找不到自己想要的内容,还有时候就是,网页特别复杂,网页的结构层次也十分复杂,你不知道该如何匹配,当你认真的学习了XPath之后,这些问题就会迎刃而解。

2. 如何安装使用XPath

XPath属于lxml库,所以首先我们需要安装这个库,这个库的具体安装步骤我已经写在我的博客里面了大家可自行翻阅。

安装好之后我们将使用from lxml import etree和Selector = etree.HTML(网页源代码)和Selector.xpath(一段神奇的代码)

二. 神器XPath的使用

1. XPath与HTML结构

HTML是树状结构,他可以逐层展开,我们利用这一特点结合XPath就可逐层定位

下面请看一个小的页面,我们接下来的测试用例会讲到这个页面。

用chrome打开这个网页,然后打开检查,如下界面(这里我把全部的信息显示出来,便于分析检查)

2. 获取网页元素的XPath

手动分析法

这里我们分析一下,如果我们需要找到“这是第一条信息”我们通过下面的方式去查找

html->body->div->ul[@useful]->li

补充说明:上面的这段内容肯定不是XPath的代码,这里只是一种形象的表示方法。大家查看上图可以发现ul标签有两个内容,这里我们选择的是id等于useful的标签,所以上面的形象查找部分是ul[@useful],另外就是这里我想要查找的是“这是第一条信息”但是我上面的只有li,大家很容易就明白了,这里返回的应该是一个列表,列表的内容包括了三条信息,“这是第一条信息,这是第二条信息,这是第三条信息”

Chrome分析法

手动分析法,在结构比较复杂的网页中分析起来还是比较麻烦,这里我们可以使用chrome分析法,准确快速的定位。我们右击页面,点击检查,或者审查元素,弹出他的代码结构,然后在我们感兴趣的内容对应的代码上面右击,选择Copy,然后选择Copy XPath,把它复制下来,我把刚刚那段感兴趣的内容粘贴下来,大家和上面的手动分析比较一下

//*[@id="useful"]/li[1]

是不是和咱们手动分析的内容有几分类似呢。分析一下chrome给我们的代码,这里有一个*号,而我们手动分析的代码是html,body…这是因为id=useful的这个id只有一个内容,所以我们这里用*进行了省略,如果我们在其他的标签下面也有id=useful这样的内容,是需要像我们手动分析的那样的类似的内容的。代码中li[1]就表示我们的列表里面的第一段内容了,这里就不会出现我们手动分析中的把三段内容都抓取下来的结果了。

3. 应用XPath提取内容

//定位根节点

/往下层寻找

提取文本内容:/text()

提取属性内容:/@xxxx (xxxx是属性的名字)

下面就是代码部分,具体部分的讲解内容和XPath的使用,我已经注释到代码部分了,大家可以仔细阅读:

#-*-coding:utf8-*-

from lxml import etree #导入etree

#下面是一个多行字符串,实际就是一个小网页的源代码

html = '''

<!DOCTYPE html>

<html>

<head lang="en"><meta charset="UTF-8"><title>测试-常规用法</title>

</head>

<body>

<div id="content"><ul id="useful"><li>这是第一条信息</li><li>这是第二条信息</li><li>这是第三条信息</li></ul><ul id="useless"><li>不需要的信息1</li><li>不需要的信息2</li><li>不需要的信息3</li></ul><div id="url"><a href="http://jikexueyuan.com">极客学院</a><a href="http://jikexueyuan.com/course/" title="极客学院课程库">点我打开课程库</a></div>

</div></body>

</html>

'''selector = etree.HTML(html) #使用etree将多行字符串转化成XPath可以识别的对象,然后传递给selector#提取文本

#运行的结果是打印出了“这是第一条信息,这是第二条信息,这是第三条信息”#运用XPath中的/text()获取标签li里面的内容,其中id="useful",限定了ul,而不是所有的ul

#这里如果我们把限定条件给去掉,下一句的代码变成了content = selector.xpath('//ul/li/text()')

#则打印的结果是“这是第一条信息,这是第二条信息,这是第三条信息,不需要的信息1,不需要的信息2,不需要的信息3”

#因为这里的ul[@id="useful"]是独一无二的,我们不必担心,当然,如果我们想保险一点的话,还可以在ul的前面,加上他的上一层标签

#//div/ul[@id="useful"]/li/text()我们还可以在div的后面添加代码变成div[@id="content"]

content = selector.xpath('//ul[@id="useful"]/li/text()')

for each in content:print each#提取属性,下面代码的运行结果是打印出上面网页代码中的两个链接

#这里就使用了上文所讲的方式,提取属性内容:/@xxxx (xxxx是属性的名字)

#这里的网页比较简单,当我们做其他的操作时,肯定不能像这个一样,我们就可以像上文一样给它加限定比如下面的代码

#//div[@id="url"]/a/@href

link = selector.xpath('//a/@href')

for each in link:print each#下面这段代码的结果是提取“极客学院课程库”这些内容,大家可以尝试一下

title = selector.xpath('//a/@title')

print title[0]

下文的截图是代码运行的结果

三. 神奇XPath的特殊用法

1. 以相同的字符开头的情况

starts-with(@属性名字,属性字符相同部分)

2. 标签套标签

string(.)

下面是代码详解

#-*-coding:utf8-*- from lxml import etree#首先将一下下面代码的困难之处,在html1中的body标签下的div标签里面,有三个id,且三个id不同 #这就是我们需要处理的第一类问题,以相同的字符开头的情况 html1 = ''' <!DOCTYPE html> <html> <head lang="en"><meta charset="UTF-8"><title></title> </head> <body><div id="test-1">需要的内容1</div><div id="test-2">需要的内容2</div><div id="testfault">需要的内容3</div> </body> </html> '''#在接下来的html2中出现标签套标签 html2 = ''' <!DOCTYPE html> <html> <head lang="en"><meta charset="UTF-8"><title></title> </head> <body><div id="test3">我左青龙,<span id="tiger">右白虎,<ul>上朱雀,<li>下玄武。</li></ul>老牛在当中,</span>龙头在胸口。</div> </body> </html> '''selector1 = etree.HTML(html1) #下面代码里面//div[starts-with(@id,"test")]/text()'注意讲到的一个新用法,这里的意思是,标签id中以“test”开头的所有标签都会被提取出来 #运行的结果是“需要的内容1,需要的内容2,需要的内容3” content1 = selector1.xpath('//div[starts-with(@id,"test")]/text()') for each in content1:print each#下面的代码是标签套标签的错误使用,就是我们利用上一章节的使用方法 #直接提取div[@id="test3"],运行的结果是只能提取div里面的内容,而div里面嵌套的标签的内容无法提取 #运行的结果是“我左青龙 龙头在胸口”,这显然不是我们想要的内容 selector2 = etree.HTML(html2) content_2 = selector2.xpath('//div[@id="test3"]/text()') for each in content_2:print each#下面的内容就是我们提取的完整的内容 #我们这里的思想还是先大后小的思想,我们先提取div下面的所有的内容 #然后直接使用info = data.xpath('string(.)'),但是注意的是这一句执行的结果会把换行,空格都给提取出来 #所以我们需要使用替换,把换行符合空格符全部替换掉 #运行的结果是我左青龙,右白虎,上朱雀,下玄武。老牛在当中,龙头在胸口。 selector3 = etree.HTML(html2) data = selector3.xpath('//div[@id="test3"]')[0] info = data.xpath('string(.)') content_3 = info.replace('\n','').replace(' ','') print content_3

四. Python并行化介绍与演示

1. 并行化简单理解

这里可以理解为Python的多线程(这里的多线程不是真正的多线程)

多个线程同时处理任务,提高效率,具有高效和快速的特点

2. map使用实现爬虫并行化

map函数包括序列操作,参数传递和结果保存等一系列操作

使用map函数时需要导入Pool这个类,使用代码:

from multiprocessing.dummy import Pool

根据自己的计算机核数的不同,下面的代码使用的数字有改动:

pool = Pool(4)

接着使用result = pool.map(爬取函数,网址列表)

下面是代码详解:

#-*-coding:utf8-*-#导入map所在的Pool这个类,然后重新命名为ThreadPool

#导入requests抓取网页源代码

#导入time计算时间,比较单线程和多线程的时间

from multiprocessing.dummy import Pool as ThreadPool

import requests

import time#定义了一个函数,其作用是获取传入的URL的源代码

def getsource(url):html = requests.get(url)urls = []#下面的这些代码生成20行网址,这里range函数使用头但是不使用尾,所以这里传入的是21

for i in range(1,21):newpage = 'http://tieba.baidu.com/p/3522395718?pn=' + str(i)urls.append(newpage) #将这二十个网址全部添加到urls这个列表里面time1 = time.time() #该语句的作用是记下程序运行到这一步的时间

for i in urls:print igetsource(i)

time2 = time.time() #记下时间2

print u'单线程耗时:' + str(time2-time1) #两个时间相减就是上面这段代码执行完的总时间#使用Python的并行化操作

pool = ThreadPool(4) #初始化一个实例

time3 = time.time()

results = pool.map(getsource, urls) #使用getsource和map函数进行爬取

#map的作用就是并行的处理getsource这个函数,然后传入的是urls的内容

pool.close()

pool.join()

time4 = time.time()

print u'并行耗时:' + str(time4-time3)#运行结果是单线程爬虫比多线程爬虫的时间要长的多#这里map只是做一个了解,以后还会讲到scrypy

五. 实战—百度贴吧爬虫

目标网站:http://tieba.baidu.com/p/3522395718

目标内容:跟帖用户名,跟帖内容,跟帖时间

涉及知识:

requests爬取网页源代码

XPath提取内容

map实现多线程爬虫

请看代码分析:(这之前你得熟悉想要找的内容,这里建议大家使用chrome的检查或者审查元素功能)

#-*-coding:utf8-*-

from lxml import etree #需要使用XPath的etree

from multiprocessing.dummy import Pool as ThreadPool #使用多线程爬虫

import requests #抓取网页的源代码

import json #这里导入了json的库,是因为源代码中有一部分是用json保存的,这里以后会说到

import sysreload(sys)sys.setdefaultencoding('utf-8') #上面三行代码的作用是使内容强制转化成utf-8,不然会出现乱码'''重新运行之前请删除content.txt,因为文件操作使用追加方式,会导致内容太多。'''#定义了一个函数,将内容写入文本中

def towrite(contentdict):f.writelines(u'回帖时间:' + str(contentdict['topic_reply_time']) + '\n')f.writelines(u'回帖内容:' + unicode(contentdict['topic_reply_content']) + '\n')f.writelines(u'回帖人:' + contentdict['user_name'] + '\n\n')#爬虫函数

def spider(url):headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/55.0.2883.87 Safari/537.36'}html = requests.get(url,headers = headers) #获取网页源代码#print htmlselector = etree.HTML(html.text) #将其转化成可以使用XPath处理的对象content_field = selector.xpath('//div[@class="l_post l_post_bright "]') #获取一整个div,这里使用了先抓大后抓小的技巧item = {} #定义了一个字典for each in content_field:reply_info = json.loads(each.xpath('@data-field')[0].replace('"','')) #再次使用XPath,抓取每一个回帖里面的评论内容#其中还使用了替换和json.loads,将json的内容转换成字典格式author = reply_info['author']['user_name'] #使用字典的形式将作者的信息进行存储#下面的代码获取所有评论信息content = each.xpath('div[@class="d_post_content_main"]/div/cc/div[@class="d_post_content j_d_post_content "]/text()')[0]reply_time = reply_info['content']['date']print content #将获取的信息打印出来print reply_timeprint authoritem['user_name'] = author#将信息传入到字典里面item['topic_reply_content'] = contentitem['topic_reply_time'] = reply_timetowrite(item)if __name__ == '__main__':pool = ThreadPool(4) #此处是为了实现多线程爬虫,提高效率f = open('content.txt','a') #打开一个文件#生成20个网页链接,将其保存在一个列表中page = []for i in range(1,5):newpage = 'http://tieba.baidu.com/p/3522395718?pn=' + str(i)page.append(newpage)print page# results = spider('http://tieba.baidu.com/p/3522395718?pn=1')results = pool.map(spider, page) #使用并行技术将其爬取下来pool.close()pool.join()f.close()

相关文章:

html无序列表空心圆_列表样式的使用CSS入门基础(018)

今天我们分享关于列表样式的内容。列表项list-sytle-type:在HTML学习中,我们知道有有序列表和无序列表,都是使用type属性来定义的。1、有序列表有序列表 有序列表 有序列表 属性值type:1,数字1、2、3……;…

2013年3月百度之星B题

Sigma Time Limit : 2000/1000ms (Java/Other) Memory Limit : 65535/32768K (Java/Other) Problem Description 小H是一个程序员。他很喜欢做各种各样的数学题,尤其喜欢做《水泥数学》。 在看了《水泥数学》的2.5章后,小H终于会用9种计算 1^22^2...n^…

TCP/IP 10.1集成IS-IS协议

樱桃小小的 软软的甜甜的好吃哈!感谢上帝 , 恩呢 , 让我吃的这么满足,开心!第十章 集成IS-IS协议建议在学习ISIS的时候联系2个<?xml:namespace prefix o ns "urn:schemas-microsoft-com:office:office"…

运维基础-文件权限管理

Linux是一个多用户操作系统,在多用户操作系统上我们需要一种方法来允许或者拒绝访问特定的文件和目录。文件有所属人和相关的单个组。我们可以设置所属人或者租的权限,以及所有其他人的权限。 文件只具有三个应用权限的用户类别。文件的所有者࿰…

android帧动画实现方法之一

好多动画离不开帧动画的使用,下面就实现帧动画的制作方式之一,以后会推出其他方法。 上面是文件存放位置。 a.xml文件的代码如下: <?xml version"1.0" encoding"utf-8"?> <animation-list xmlns:android"…

python技术晨讲_python系列教程14

声明:在人工智能技术教学期间,不少学生向我提一些python相关的问题,所以为了让同学们掌握更多扩展知识更好的理解人工智能技术,我让助理负责分享这套python系列教程,希望能帮到大家!好了,是开始…

三字母词和转义字符

1. 三字母词 在C语言中有一种三字母词的说法,trigraph sequences,目前为止有九种三字母词,如下 ?? # ??) ] ??! | ??( [ …

写了个Python脚本监控nginx进程

写了个Python脚本监控nginx进程 Xiaoxia[PG]写了个Python脚本监控nginx进程接上一文用iptables让SSH服务对陌生人说不。还是有点担心这个学期内,nginx可能会因为系统各种原因而出现异常退出,导致Web服务暂停。所以,又来了一个方案。view pla…

Linux shell 脚本报错:/bin/bash^M: bad interpreter: No such file or directory

今天遇到一个很诡异的问题,一直运行很正常的shell脚本失败了,只是昨天增加了一个参数而已。 报错信息: /bin/bash^M: bad interpreter: No such file or directory 后来发现root cause, 昨天修改文件的时候在windows中修改保存,然…

C语言volatile关键字详解

volatile提醒编译器它后面所定义的变量随时都有可能改变,因此编译后的程序每次需要存储或读取这个变量的时候,都会直接从变量地址中读取数据。如果没有volatile关键字,则编译器可能优化读取和存储,可能暂时使用寄存器中的值&#…

python储存数据的容器_Python基础四容器类数据

一、上周内容回顾int bool str 之间的互相转换int str:str(int)int(str) #字符串必须是数字组成int bool:bool(int):非零即TrueTrue --->1 Fasle --->0bool str:str-->bool #非空即Truestr:BIF自己去背吧二、列表why:1.取值费劲。2.对字符串…

Android 清单文件 详解

转载于:https://www.cnblogs.com/mohe/archive/2013/03/31/2991642.html

android屏幕分辨率详解 ldpi mdpi hdpi 程序UI自适应 《官方翻译》

2019独角兽企业重金招聘Python工程师标准>>> 看世界杯的空闲 时间,翻译一下 官方文档。分辨率 问题是大家都很关心的(720480会不会悲剧),而关于这个问题,android官方的文档无疑最有说服力。由于不是所有的人…

010 并发的三个特性

一 . 概述 在之前,我们使用synchronized关键词解决了原子性的操作,本节我们分析一个JVM内存模型导致的另外的两个问题. 二 . 可见性 为了加速线程的运行的速度,JVM的内存模型中设置了线程栈中的缓存,当一个线程使用了堆内存的数据的时候,首先会将这个数据缓存到线程栈之中, 当这…

LeetCode: Longest Consecutive Sequence

想到map了,可惜没想到用erase来节省空间,看了网上答案 1 class Solution {2 public:3 int longestConsecutive(vector<int> &num) {4 // Start typing your C/C solution below5 // DO NOT write int main() function6 …

python做测试书籍推荐_学习pytest应该观看的书籍?

这本书有中文版了pytest是动态编程语言Python专用的测试框架,它具有易于上手、功能强大、第三方插件丰富、效率高、可扩展性好、兼容性强等特点。《pytest测试实战》深入浅出地讲解了pytest的使用方法,尤其是具有特色的fixture的用法。作者通过丰富的测试…

路由器、路由与路由表

2019独角兽企业重金招聘Python工程师标准>>> 路由器、路由与路由表 路由器就是一台网络设备,它配备多个网络接口卡(NIC),能利用它的网络知识正确转发入口流量。 决定一个入口封包应当送给本地主机还是转发所需要的信息,以及在转发…

Hadoop虚拟机的jdk版本和本地eclipse的版本不一致怎么办

在本周学习Hadoop遇到了一个问题,困扰了半天,本人在安装Hadoop时是按照视频来的,结果发现Hadoop上的jdk版本和本地eclipse的版本不一致,导致本地的程序到处jar包传到虚拟机上运用Hadoop不能正常运行,如果你遇到相同的问…

操作符和表达式

一. 操作符 1. 算术操作符 - * / % 除了%之外其余的几个操作符既可以用于计算整型也可以用于计算浮点型数据,%只能计算整型数据,得到的结果是余数 2. 移位操作符 << 左移位操作符 >> 右移位操作符 <<左移…

kuayu react_react跨域解决方案

react跨域解决方案1.开发环境:reactaxioselement2.电脑系统:windows10专业版3.在使用react开发的过程中,我们总是会遇到跨域的问题,下面我来分享一下,在react中跨域处理方法!4.我使用的是axios向后台发送请求,安装axios:npm i axios --save5.安装代理中间件(http-proxy-middlew…

HDU 1429 胜利大逃亡(续) (BFS+位压缩)

题目链接:http://acm.hdu.edu.cn/showproblem.php?pid1429 胜利大逃亡(续) Time Limit: 4000/2000 MS (Java/Others) Memory Limit: 65536/32768 K (Java/Others) Total Submission(s): 3309 Accepted Submission(s): 1063 Problem DescriptionIgnatius再次…

Ext fucionchart插件

http://code.google.com/p/uxmedia/downloads/list转载于:https://www.cnblogs.com/jerome-rong/archive/2012/06/09/2543565.html

前端 ----jQuery的动画效果

03-jQuery动画效果 jQuery提供的一组网页中常见的动画效果,这些动画是标准的、有规律的效果;同时还提供给我们了自定义动画的功能。 显示动画 方式一: $("div").show(); 解释:无参数,表示让指定的元素直接显…

结构和联合--结构体内存和位段内存开辟规则

一. 结构的基本知识 聚合数据类型能够存储多个数据,C语言提供了两种类型的聚合数据类型,数组和结构。数组是相同的数据,结构是不同类型的数据聚合。结构也是一些值得集合,这些值成为它的成员,每个结构都有它的名字&a…

antd自定义分页器_自定义分页器

classPagination(object):def __init__(self, current_page, all_count, per_page_num10, pager_count11):"""封装分页相关数据:param current_page: 当前页:param all_count: 数据库中的数据总条数:param per_page_num: 每页显示的数据条数:param pager_count:…

.net实现跨页面传值

//一般用于向php,jsp等传值,因为跨语言session等不能共用,只有通过post提交 //下面演示的是服务器端控件提交 PostBackUrl"WebForm3.aspx"//这个页面只需要修改控件属性就能把值传给下一页面 protected void Page_Load(object send…

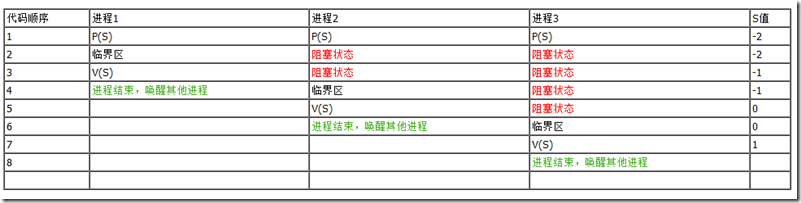

进程的同步、互斥以及PV原语

在处理进程间的同步与互斥问题时,我们离不开信号量和PV原语,使用这两个工具的目的在于打造一段不可分割不可中断的程序。应当注意的是,信号量和PV原语是解决进程间同步与互斥问题的一种机制,但并不是唯一的机制。 信号量ÿ…

ListT中,Remove和RemoveAt区别

Remove删除的是匹配的第一项。比如你的list里面有2个相同的项。那么就删除第一个。后面的不删除,找不到元素和删除失败都返回falseRemoveAt是删除索引下的项 转载于:https://www.cnblogs.com/mcyushao/p/9526208.html

vue 如何处理两个组件异步问题_Vue动态异步组件实现思路及其问题

前言:在vue官方资料中,我们可以可以很学会如何通过vue构建“动态组件”以及“异步组件”,然而,在官方资料中,并没有涉及到真正的“动态异步”组件,经过大量的时间研究和技术分析,我们给出目前比…

[转载] 七龙珠第一部——第004话 掳人的妖怪——乌龙

转载于:https://www.cnblogs.com/6DAN_HUST/archive/2013/04/07/3003566.html